メイン > 雑記:データ解析

2020年3月11日 (水)

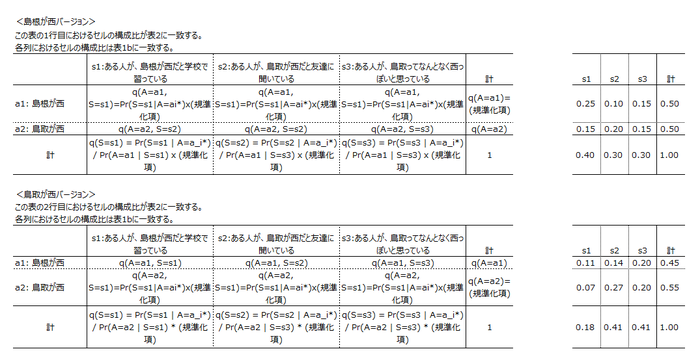

仕事の都合であれこれ考えていたらわけがわからなくなってしまったので、ちょっとシミュレーションをやってみたら、さらに新たな疑問が生じ... という話を記録しておく。

背景

ある量的変数の時系列 $Y_t$ があって、それに影響を及ぼしているであろうなんらかの変数の時系列$X_t$があるとする。なんでもいいんだけど、たとえば売上と広告出稿量とか。

で、$Y_t$に対する$X_t$の効果の大きさをデータから推定したい。こういうこと、よくありますよね。

話を簡単にするために、分析者は次のことを知っているとしよう。

- $X_t$の$Y_t$に対する効果は即時的、かつ線形である。つまり、

$Y_t = \alpha + \beta X_t + V_t$

とモデル化できる。 - $X_t$は定常である。なんでそんなことを知っているのかわからんが、なにか実質的な知識があるのでしょう。

- $Y_t$の撹乱項$V_t$は一次自己回帰過程 (AR(1)過程)に従う。つまり、

$V_t = \rho V_{t-1} + E_t, \ \ E_t \sim N(0, \sigma_E^2)$

とモデル化できる。これも、まあ、ありそうな仮定ですわね。時系列の自己相関関数を観察した結果、これAR(1)でいいんじゃね? と思うことはさほど珍しくないと思う。 - 自己回帰係数$\rho$は$0 \leq \rho \leq 1$である。つまり、$V_t$は非負の自己回帰係数を持つ定常AR(1)過程に従う($0 \leq \rho <1$)か、単位根AR(1)過程に従う($\rho = 1$)かのどちらかである。これもそれほど変な仮定ではないと思う。自己回帰はふつう正だし、もし負だったらデータの観察でそれと気がつくだろう。仮に$\rho >1$なら$V_t$はどっかに飛んでいってしまうはずなので、これも除外できる。でも、$\rho <1$か$\rho = 1$かは簡単には判断できない。

問題

さて、分析者が関心を持っているのは$\beta$である。ここで疑問なのは、$\beta$の推定誤差は$\rho$とどういう風に関連しているのか、という点である。特に次の点について知りたい。

- Q1. $\rho$が大きいとき、つまり結果変数の撹乱項が高い自己相関を持つとき、$\beta$の推定誤差は大きくなるか、それとも小さくなるか。

- Q2. $\rho = 1$であるのにそれと知らず、$\rho < 1$と仮定するモデルを推定したとき、$\beta$の推定誤差は大きくなるか。

いずれも、私にとってはちょっと切実な疑問だ。

Q1についていえば... 仕事のなかで時系列データの分析が生じる際、まずは目的変数の時系列を観察して、これからわざわざ説明変数のデータを集めモデリングする労力は報われるかしらん? と算段することが多いと思う。そういう場面での手掛かりがほしい。見通しが暗いなら早めに白旗を上げたい。

Q2についていえば... 理屈の上からいえば、$\rho=1$かそうでないかでAR(1)過程の挙動はがらっとかわる。でも、実データの背後にあるデータ生成プロセスが$\rho=1$かどうかなんて、どうせわかりっこない。だから、きっと$\rho<1$だよねと信じてAR(1)誤差を仮定したり、いや$\rho=1$にちがいないと信じて差分時系列を分析したりするわけである(そんなことないですか?)。でも心には常に不安の影が付きまとう。$\rho$についての仮定をしくじることが、$\beta$の推定にとってどのくらい致命的なのかを知りたい。

方法

気になって夜も眠れないので(大げさな表現)、簡単なシミュレーションをやってみました。

$t=-100,\ldots,100$について、データを次のように生成した。

$x'_t \sim unif(0, 1)$

$e_t \sim N(0, 1)$

$v_t = \rho v_{t-1} + e_t$

$y'_t = x't + v_t$

つまり$\beta = 1$である。で、$x'_t, y'_t$から$t=1$以降を切り出し、それぞれを中心化する。これを$x_t, y_t$とする。

$\rho$を$0, 0.1, 0.2, \ldots, 1.0$の11通りに動かし、それぞれについて1000個のデータセットを生成した。

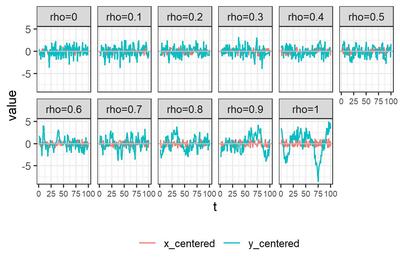

それぞれについてデータセットをひとつ選び$x_t, y_t$を描画すると、こんな感じである。

モデルの推定方法として、次の6つを試す。

- A. 単にOLS推定

- B. Rのforecast::Arima()でML推定

- C. Rのnlme::gls()でFGLS推定

- D. 状態空間モデルとして定式化し、RのKFASパッケージを使ってカルマンフィルタで推定

- E. Mplusでベイズ推定

- F. Stanでベイズ推定

推定にあたっては、次の5つのアプローチを試してみる。

- アプローチ1. $\rho = 0$と仮定して、

$y_t = \beta x_t + e_t$

$e_t \sim N(0, \sigma_e^2)$ - アプローチ2. $|\rho| < 1$と仮定して、

$y_t = \beta x_t + v_t$

$v_t = \rho v_{t-1} + e_t, \ \ |\rho| < 1$

$e_t \sim N(0, \sigma_e^2)$ - アプローチ3. $\rho = 1$と仮定し、$\Delta y_t = y_t - y_{t-1}, \Delta x_t = x_t - x_{t-1}$について、

$\Delta y_t = \beta \Delta x_t + e_t$

$e_t \sim N(0, \sigma_e^2)$ - アプローチ4. $y_t$について単位根検定を行い、単位根を持たないと判断されたらアプローチ2, 持つと判断されたらアプローチ3に進む。

- アプローチ5: アプローチ2と同じなんだけど、$\rho$の範囲について仮定しない。

私の乏しい理解では、A(OLS), B(ML), C(FGLS)では撹乱項の定常性が仮定されるので、アプローチ5は選べない。いっぽうD(カルマンフィルタ), E,F(ベイズ)では、$\rho$を明示的に制約しないかぎりアプローチ5になる... というように理解しているのだけれど、ここ、全然自信がない。悲しい。誰か私に教えてくださらないでしょうか。

まあいいや!とにかくシミュレーションしてみたのであります。

単位根検定

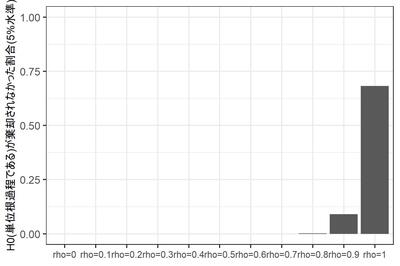

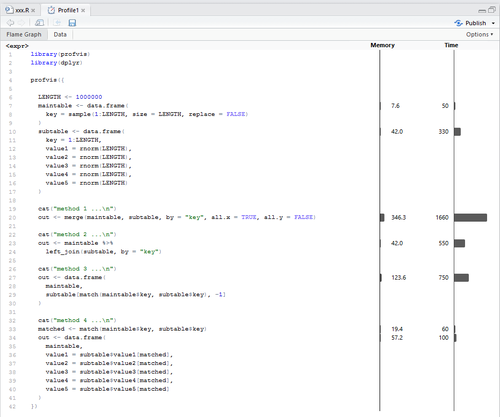

まず、アプローチ4で必要になる単位根検定の結果について紹介しておく。Dickey-Fuller検定を使った。Rコードはこんな感じ。$y_t$がdfIn$y_centeredにはいっている。

library(urca)

oDFTest <- ur.df(dfIn$y_centered, type = "none", lags = 1)

nD <- if_else(oDFTest@teststat[1,1] < oDFTest@cval[2], 0, 1)

トレンドもドリフトもないAR(1)であると知っているので、type ="none", lags=1と決め打ちしている。$H_0: \rho=1$が 5%水準で棄却されたら$\rho<1$と判断し、そうでなかったら$\rho=1$と判断することにして、後者の場合にnDを1としている。

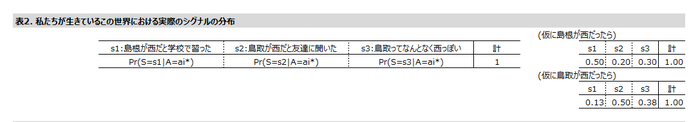

素朴に考えると、本当は$\rho=1$であるデータセットのうち95%くらいが$\rho=1$と判断されてほしい($H_0$が真のときに誤って棄却される確率は5%であってほしい)。本当は$\rho<1$である場合は、なるべく多くのデータセットが$\rho<1$と判断されてほしい。

さて、11通りの$\rho$の、それぞれ1000個のデータセットのうち、$\rho = 1$と判断されたデータセットの数は?

蓋をあけてみると... $\rho=1$であるデータセットのうち、$H_0$が棄却されなかった($|\rho|=1$と判断された)データセットは95%には到底及ばず、実に68%にとどまる。なぜだろう? よくわからない。

$\rho<1$であるにもかかわらず$H_0$が棄却されないデータセットは、当然ながら$\rho$が1に近づくにつれて増えるのだが、それでも$\rho = 0.9$のときに9%。$\rho = 0.8$までではほとんど生じない。

このように、DF検定の場合、保守側($H_0: \rho = 1$が棄却されない側)に大きくバイアスがかかるようだ。$H_0$を反対側に設定するPP検定であればまた違う結果になるだろうけど...

まあとにかく、ここで確認しておきたいのは、$\rho = 1$かそうでないかなんて、そんなに簡単にはわからないよね、ということである。

選手紹介

お待たせしました、選手入場です。拍手でお迎え下さい。

A. 単にOLS推定。アプローチ1($\rho=0$と仮定)のRコードは

oModel <- lm(y_centered ~ 0 + x_centered, data = dfIn)

自己相関を華麗にスルーしちゃうわけだが、これ、それほど捨てたもんじゃないと思う次第である。だって、$|\rho| < 1$であれば、$\hat{\beta}$は少なくとも一致推定量ではあるわけでしょう?

アプローチ1, 3($\rho=1$と仮定)を試してみる。

B. forecast::Arima()で最尤推定。Rによる時系列モデリングの定番 forecast パッケージはArima()という関数をご用意している(実はstat::arima()へのラッパーである)。アプローチ2($|\rho|<1$と仮定)のRコードはこんな感じ。

library(forecast)

oModel <- Arima(

y = dfIn$y_centered,

include.mean = FALSE,

order = c(1, 0, 0),

xreg = dfIn$x_centered ,

method = "ML"

)

アプローチ3($\rho=1$と仮定)ならorder = c(0,1,0)となる。アプローチ2, 3, 4(DF検定で切り替え)を試す。

C. nlme::gls()でFGLS推定 ついでにnlme::gls()でFGLS推定を試してみる。計量経済学の教科書に載っているのは、最尤推定じゃなくてこっちのほうですね。

アプローチ2($|\rho|<1$と仮定)のRコードはこんな感じ。

library(nlme)

oModel <- gls(

y_centered ~ 0 + x_centered,

corr = corARMA(p=1, q=0),

data = dfIn

)

アプローチ2のみ試す。

D. 状態空間モデルとして定式化し、RのKFASパッケージを使ってカルマンフィルタで推定。おさらいすると、アプローチ2,5のモデルは

$y_t = \beta x_t + v_t$

$v_t = \rho v_{t-1} + e_t, \ \ e_t \sim N(0, \sigma_e^2)$

である。これを状態空間表現に書き換えよう。状態変数は$\beta$と$v_t$だと考え、縦に積んで$\alpha_t = [\beta, \ v_t]'$としよう。

観察方程式は

$Y_t = Z \alpha_t$

ただし $Z = [x_t, 1]$である。撹乱項がないことに注意。状態方程式は

$\alpha_t = T \alpha_{t-1} + R \eta, \ \ \eta \sim MVN(0, Q)$

遷移行列$T$は2x2の対角行列で、対角要素は$1, \rho$である。$R$は2x2の単位行列で、状態撹乱項は$\eta = [0, e_t]'$とする。共分散行列$Q$は2x2で、右下に$\sigma_e^2$がはいり、残りが0。

こいつをカルマンフィルタで推定する。Rコードはこんな感じ。遷移行列$T$に未知パラメータが入っているので、ちょっと面倒くさい。

library(KFAS)

mgZ <- array(dim = c(1, 2, nrow(dfIn)))

mgZ[1,1,] <- as.vector(dfIn$x_centered)

mgZ[1,2,] <- 1

oModel <- SSModel(

dfIn$y_centered ~ -1 + SSMcustom(

Z = mgZ,

T = matrix(c(1, 0, 0, 1), nrow = 2), # 最後の要素がrho

R = matrix(c(1, 0, 0, 1), nrow = 2),

Q = matrix(c(0, 0, 0, 1), nrow = 2), # 最後の要素がsigma_e

P1 = matrix(c(0,0,0,0), nrow = 2),

P1inf = matrix(c(1,0,0,1), nrow = 2)

),

H = matrix(0)

)

sub_update <- function(par, model){

# par: (sigma_eの対数, rho)

# model: 現在のモデル

model$T[2,2,1] <- par[2]

model$Q[2,2,1] <- exp(par[1])

return(model)

}

oFitted <- fitSSM(

oModel,

inits = c(log(var(dfIn$x_centered)/2), 0.5) ,

updatefn = sub_update,

lower = c(-10, -2),

upper = c(+10, +2),

method = "L-BFGS-B"

)

oEstimated <- KFS(oFitted$model)

計算の都合上$|\rho| < 2$と制約しているものの、このモデルは$|\rho| = 1$という仮定を置かないモデル、つまりアプローチ5ということになると思うのですが... 正しいでしょうか?

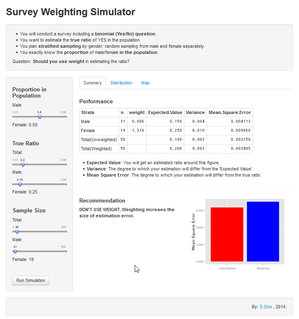

E. Mplusでベイズ推定。ここまではRなどという古くさい言語を使っておりましたが、いけてる分析者なら、ここは当然 Mplus ですよね! (すいません冗談です)

構造方程式モデリングの世界ではもはや標準となっているソフトウェア Mplus だが、実はN=1の時系列分析についても便利な機能を持っているのである。

Mplusのコードはこんな感じ。

DATA:

FILE = est2.dat;

VARIABLE:

NAMES = y x;

MISSING=.;

ANALYSIS:

ESTIMATOR = BAYES;

BITERATIONS = (2000);

MODEL:

v by (&1);

v;

v on v&1;

y on v@1 x;

[y@0];

y@0;

MODELコマンドがわかりにくいが、1行目は「vは潜在変数ですが指標を持っていません。モデルのなかでラグ1を使わせて下さい」。2行目は「その残差分散(つまり$\sigma_e$)を自由推定したいです」。3行目で$v_t$の自己回帰を定義し(v&1とは$v_{t-1}$を表す)、4行目で$y_t$のモデルを定義している($v_t$の回帰係数は1に固定している)。ほっとくと$y_t$の切片と残差分散を推定してしまうので、最後の2行でそれを抑止している。

このとき$v_t$の自己回帰係数($\rho$)は範囲が制約されていない、つまりアプローチ5だ、というのが私の理解なのだが、正しいだろうか...?

F. Stanでベイズ推定。ほんとはここまでやるつもりはなかったんだけど、毒も食らわば皿まで、ということで... Stanファイルはこんな感じ。

data {

int T;

vector[T] y;

vector[T] x;

}

parameters {

real beta;

real<lower=-1, upper =1> rho;

real<lower=0> sigma;

}

model {

vector[T] v;

v = y - beta * x;

v[1] ~ normal(0, sigma/sqrt(1-rho^2));

v[2:T] ~ normal(rho * v[1:(T-1)], sigma);

} 下から3行目、v[1]でなにか変なことを書いているが、これは$v_{t-1}$が未知であるときの$v_t$の周辺分布の分散が、$v_{t-1}$の下での$v_t$の条件つき分布の分散 $\sigma_e$より大きくなるからである。

どのくらい大きくなるかというと、

$v_t = \rho v_{t-1} + e_t$

の両辺の分散をとって

$Var(v_t) = Var(\rho v_{t-1} + e_t)$

$e_t$と$v_{t-1}$との共分散は0なので、

$Var(v_t) = \rho^2 Var(v_t) + \sigma_e^2$

ここから

$Var(v_t) = \sigma_e^2 / (1-\rho^2)$

である。

というわけで、尤度計算に当たってデータ点ひとつも無駄にしまいという質実剛健な精神に則り、v[1]についても誠意を込めて分布を書いてみたんだけど、でもこれって、$1-\rho^2 \neq 0$、つまり$|\rho| \neq 1$という仮定を暗黙のうちに含んでいないだろうか? そんならいっそ、というわけで、parametersブロックではreal <lower=-1, upper =1> rho; と書いた次第である。

このモデルとともに、parametersブロックでrhoの範囲制約をなくし、かつ下から3行目を消したモデルも推定してみた。前者はアプローチ2, 後者はアプローチ5に相当すると思うんだけど... うーーん、こういう理解で正しいのだろうか? からきし自信がない。

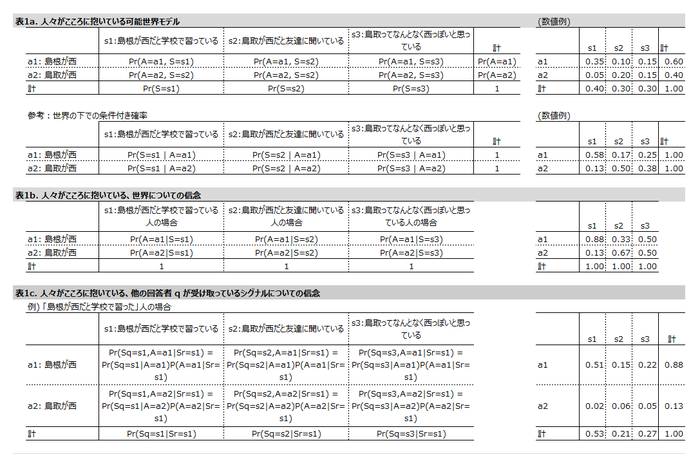

まとめると、出場選手は以下の10名である。

- A1: OLS推定, $\rho = 0$と仮定

- A3: OLS推定, $\rho = 1$と仮定

- B2: 最尤推定, $|\rho| < 1$と仮定

- B3: 最尤推定, $\rho = 1$と仮定

- B4: 最尤推定, 単位根検定に基づきモデル選択

- C2: FGLS推定, $|\rho| < 1$と仮定

- D5: カルマンフィルタ

- E5: ベイズ推定(Mplus)

- F2: ベイズ推定(Stan), $|\rho| < 1$と仮定

- F5: ベイズ推定(Stan)

推定の様子

この10人の選手に、11水準の$\rho$の各1000個のデータセットについて、$\beta$を推定させた。ただしStanは時間がかかるので、1000個のうち100個だけについて推定するだけで勘弁してやった。

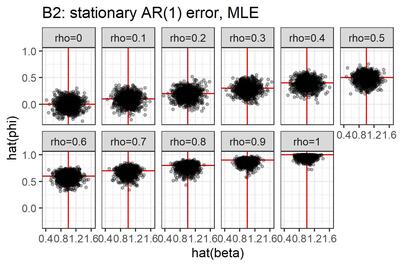

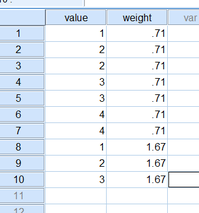

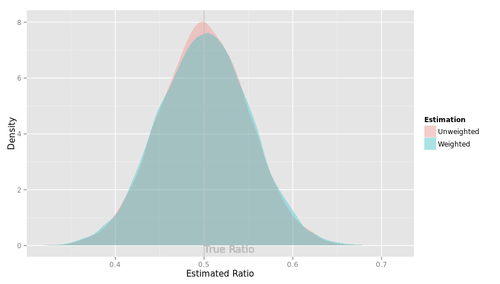

いったいなにをやっているのか、自分でもよくわかんなくなってきたので、選手B2(最尤推定, $|\rho| < 1$と仮定)による推定結果を図にしてみた。

点はデータセット、横軸は$\beta$の推定値, 縦軸は$\rho$の推定値である。真値が赤で表現してある。こうしてみると、真の$\rho$が1に近づくにつれ、$\rho$の推定値は0に向かって歪むみたいですね。横軸と縦軸の間にはあまり相関がなさそうだ。

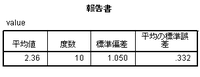

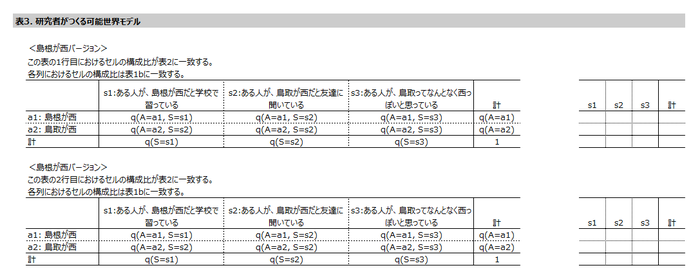

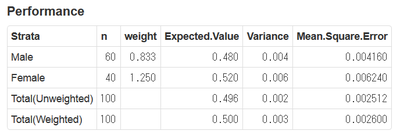

さて、関心があるのは、$\beta$の真値すなわち 1 と、$\beta$の推定値$\hat{\beta}$とのずれである。その大きさを次の2つの指標で評価しよう。

- バイアス。$\hat{\beta}$の平均から1を引いた値。0に近くないと困る。

- RMSE、すなわち$(\hat{\beta}-1)^2$の平均の平方根。0に近いほうがありがたい。

結果

大変ながらくお待たせいたしました!お待たせしすぎたかもしれません! (ちょっと懐かしい冗談だ)

結果発表です!

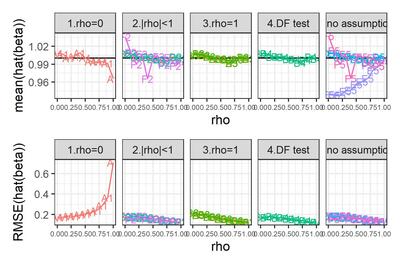

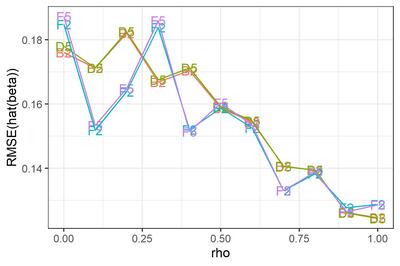

選手F2, F5のみ試行回数が100である点に注意。

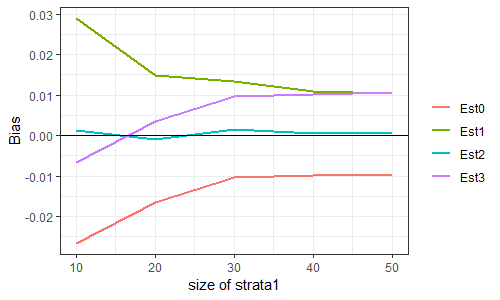

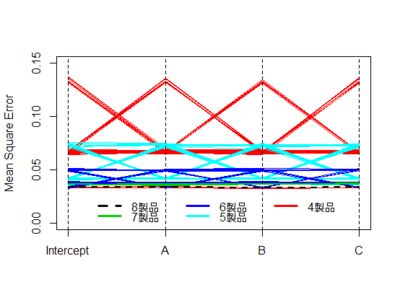

シンプルなチャートだが、なかなか情報量が多いので、順にみていこう。

まずは、$\rho = 0$と勝手に想定し、OLS回帰をやってしまった場合。

真の$\rho$がそれほど大きくなければバイアスはそれほど大きくない。しかしRMSEは$\rho$とともに増大する。$\rho$が1に近づくと、バイアス・RMSEともに急増する。なるほど、撹乱項が非定常に近づいているわけだから、パラメータがうまく推定できないのも道理である。

やっぱりあれですね、時系列を分析する際には、きちんと自己相関を考慮することが大事ですね。

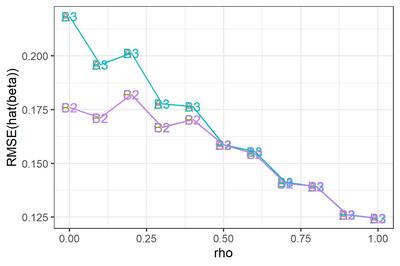

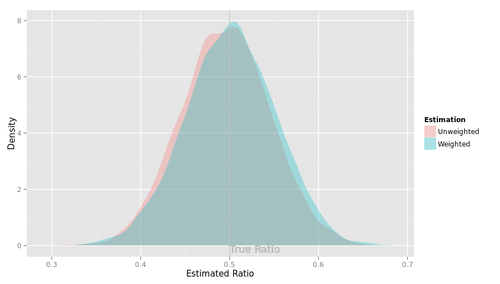

次に、$|\rho|<1$と決め打ちした場合(図のパネル2)と、$\rho=1$と決め打ちした場合(パネル3)について。バイアスはそれほど大きくないようだ。RMSEのみ拡大して示す。なお、選手F2はあとで観察することにして、ここでは省略する。

選手B2とC2, 選手B3とA3はぴったり重なってしまっている。つまり、$|\rho|<1$と決め打ちする場合、最尤推定するかFGLS推定するかにはたいしたちがいがないわけだ。$\rho=1$と決め打ちする場合に差分をとって最尤推定するかOLS推定するかも... そりゃそうか、きっと推定値は同じだ。

$\rho$が小さいとき、$\rho=1$と決め打ちするとRMSEが大きくなる。誤ったモデルを指定したわけだから、これは当然である。

これをみて大変に意外だった点がふたつある。

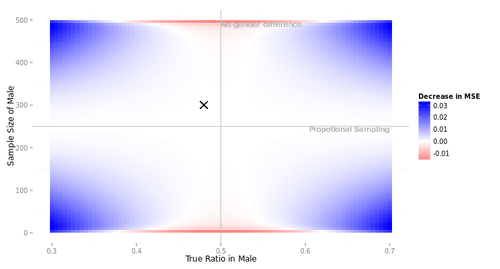

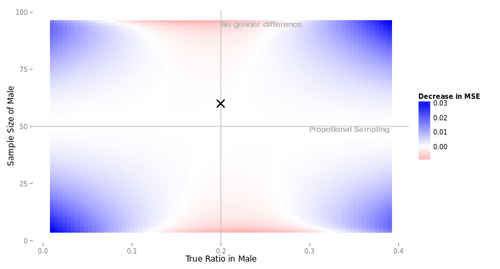

第1に、$\rho$が大きくなるにつれ、つまり撹乱項の自己相関が大きくなるにつれ、$\beta$のRMSEが小さくなっているという点である。$e_t$の分散が同じなら$\rho$が大きいほど撹乱項$v_t$の分散は大きくなるんだから、直感的には、$\beta$の推定はより難しくなるんじゃないかと思ったんだけど... なぜだろう???

もうひとつ、ふへええと言葉にならないため息をついたのは、$\rho$が1に近づくほど、$|\rho|<1$と仮定して定常AR(1)撹乱項を持つ回帰モデルを推定しても、$\rho=1$と仮定して差分時系列について回帰モデルを推定しても、違いがなくなってしまう点である。さきにみたように、単位根検定がしくじりやすいのは$\rho$が1に近いときである。そういうときほど、実は間違えたところでたいした実害はないわけだ。

このように、単位根検定でモデルを切り替えようが、頭から$|\rho|<1$と信じこんで定常AR(1)撹乱項を持つ回帰モデルを使い続けようが、ほとんどちがいがないようだ。たとえ$\rho=1$だったとしても、である。

ええええ? わざわざ単位根検定をやったのに、意味なかったわけ...?

最後に、$\rho$の範囲について制約しないモデル。

元の図にもどると、選手E5がとんでもないバイアスを持っていることがわかる。どうしたんだMplus! しっかりしろ! 医者だ、医者を呼べ!!

... 冗談はともかく、ひょっとすると私がコードを間違えているのかもしれない。残念ながらMplusくんは休場とし、他の選手についてRMSEを拡大してみよう。

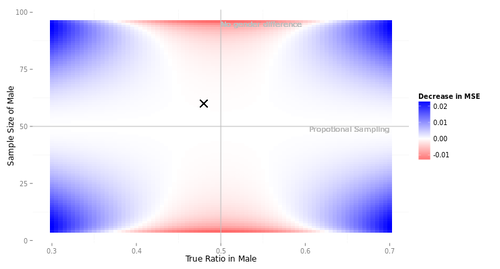

選手D5 (カルマンフィルタ) について。参考のために選手B2 (最尤推定) と並べてみた。ほとんど変わらない。

恥かしながらわたくし、撹乱項の定常性を仮定しているB2は$\rho=1$に近づくとだめになるが、定常性を仮定していないD5はうまくいく... という結果になるかな、と思っておりました。不明を恥じる次第であります。へええ、そうなのかー。

選手F5(Stanでベイズ推定)について。D5との優劣ははっきりしない。参考のためにF2 ($|\rho|<1$と仮定してStanでベイズ推定)と並べてみたところ、$\rho$が小さいところではF2が僅差で勝つが(そりゃそうだ、F2は正しい制約を追加しているわけだから)、$\rho$が1に近づくと僅差で負けるようだ。

まとめ

というわけで、シミュレーションの結果わかったことをまとめておくと、

- Q1. 時系列回帰モデル$Y_t = \alpha + \beta X_t + V_t$において、撹乱項$V_t$が高い自己相関を持つとき、$\beta$の推定誤差は大きくなるか、それとも小さくなるか。→小さくなる。

- Q2. $V_t$の自己回帰係数が1であるのにそれと知らず、1未満と仮定するモデルを推定したとき、$\beta$の推定誤差は大きくなるか。→ならない。

ううむ。どちらも意外な結果であった。勉強が足りないようだ。

それにしても、単位根検定の意味ってなんだろう? 時系列分析の教科書には必ず書いてあるけど、やっても意味なくない? ... と思ってしまったのだが、これは私が「時系列回帰で回帰係数を推定する」という場面だけに焦点を絞っているからで、たとえば予測に関心があるなら話はちがうのかもしれない。

それに、ここでは説明変数時系列が定常であると知っている場合について考えているが、もしそうでなかったら、そりゃあまあ単位根があるかどうか知りたいですわね、みせかけの回帰が怖いから。そういう意味でも、単位根の有無を調べることは、やはり大事なのでありましょう。

なお、この記事のために書いたコードはすべてGithubにアップしております。自己満足もいいところだがな!

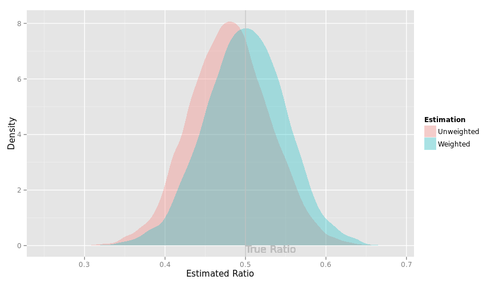

2020/03/16追記: 先週書いたこの記事を見直して、はっと気が付いたので記録しておく。

お題は次の通りである。

$y_t = \beta x_t + v_t$

$v_t = \rho v_{t-1} + e_t, \ \ e_t \sim N(0, \sigma_e^2)$

というAR(1)誤差回帰モデルで、$\rho$が大きくなるほど$\hat{\beta}$のRMSEが小さくなるのはなぜか?

2本目の式をラグ演算子$L$を使って書き直すと

$v_t = \rho L v_t + e_t$

$(1-\rho)L v_t = e_t$

ラグ多項式$(1-\rho)L$を$R(L)$とし、

$R(L) v_t = e_t$

と書くことにする。$|\rho| < 1$なら$R^{-1}(L)$が定義できて

$v_t = R^{-1}(L) e_t$

1本目の式に代入して

$y_t = \beta x_t + R^{-1}(L) e_t$

両辺に$R(L)$をかけて

$R(L) y_t = \beta R(L) x_t + e_t$

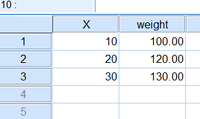

これは($\rho$を既知とすれば)通常のOLS回帰と同じなので、$x_t^* = R(L) x_t$と略記して

$\displaystyle Var(\hat{\beta}) = \frac{\sigma^2_e}{\sum(x_t^* - \bar{x}^*)^2} $

である。つまり、AR(1)誤差回帰モデルの回帰係数の標準誤差は、ふつうの単回帰のように「撹乱項の分散と独立変数の偏差平方和の比」なのでなく、「AR(1)誤差の裏にあるホワイトノイズの分散と、$x_t - \rho x_{t-1}$の偏差平方和の比」なのである。だから、自己回帰係数が大きいほど分母は大きくなり、$\hat{\beta}$のSEは小さくなるわけだ。うっわー。

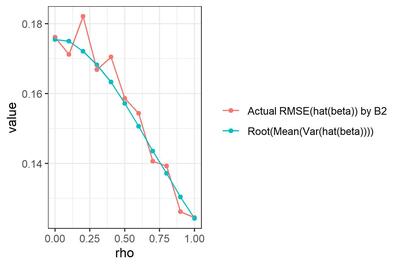

オレンジ色は、選手B2による$\hat{\beta}$の、真値($\beta=1$)に対するRMSE (再掲)。青色は、各試行について真の$\rho$を既知として$Var(\hat{\beta})$を求め、試行を通じて平均して平方根をとった値。

な・る・ほ・ど...

時系列回帰の撹乱項が自己回帰していると、いったいなにがどうなるのか(追記あり)

2020年2月29日 (土)

Rをつかっているとformulaを書かないといけないことがあるけど(回帰系の関数を呼ぶときとかに)、なんか便利な書き方がありそうなのに全然使っていない。このたび、ふとstats::formula()のドキュメントを眺めていたら、恥ずかしながら「へぇー」と思うことがいくつかあった。

この話題、Rを使っている人にとってはたぶん馴染み深い話で、webをちょっと検索するだけで、丁寧に解説しておられるブログ記事をいくつもみつけることができる(たとえばこちら:[R] 予測モデルを作るには formula を活用せよ)。そういうのをきちんと読んできちんと理解しておけばいいんですけどね。そのときは「へぇー」と思うんだけど、すぐに忘れちゃうのである。

というわけで、今日は忘れないようにメモしておこう。なぜか執事風の丁寧語で。お嬢様、羊肉のソテーでございます、って感じで。

- 「

y ~ model」: 反応yをmodelで指定した予測子でモデル化いたします。 - 「

a + b」:aとbの線形和でございます。 - 「

a : b」:aとbの交互作用でございます。 - 「

a * b」:aとbのクロス、すなわちa+b+a:bでございます。 - 「

(a + b + c)^2」:(a + b + c)の二次のクロス、すなわちa,b,cの主効果と二次交互作用でございます [これ知らなかった... 文字通り展開するとa*a, b*b, c*cが生まれるけど、それらは算術的な意味での$a^2, b^2, c^2$ではなくて、単にa, b, cの主効果ってことになるのね。へー] - 「

a + b %in% a」:bはaにネストしております。すなわちa + a:bでございます。[ここちょっと不思議なところで...%in%は常に:と等価なのかしらん?] 「(a + b + c)^2 - a:b」:(a + b + c)^2からa:bを取り除いたもの、すなわちa + b + c + b:c + a:cでございます。- 「

y ~ x - 1」: 切片項を取り除いております。y ~ x + 0,y ~ 0 + xでもよろしゅうございます [←Rを使い始めたときから、formulaの右辺で0と1が等価だってのが気持ち悪くてしかたない。責任者でてこい] 「log(y) ~ a + log(x)」: このように、算術表現もお使いになれます [←私、formulaのなかでこういう変数変換を掛けるのが生理的に許せなくて、必ず自力で前処理している。なぜ気持ち悪いのかいま気が付いた。formulaのなかの演算子は算術演算子ではないのに(たとえば+は和ではないのに)、関数は算術表現として扱われるというのが気持ち悪いんだ...]- 「

a + I(b+c)」: aとb+cの線形和でございます。I()のなかの演算子は算術演算子として扱われるのでございます。 - 「

.」: 「そのformulaのなかにないすべての列」を表します [←formulaをupdateするときはちがう意味になるのだが、まあupdateなんて使わないからいいや] - 「

a + b + offset(z)」: aとbの線形和とzとの和でございます。zの係数は1となります。なお、この表現は受け付けない関数もございます。

ところで、lm(y ~ a/b)なんていう書き方をみたことがあるけど(y ~ a + a:bと等価だと思う)、stats::formula()のドキュメントにも、stats::lm()のドキュメントにも載ってなかった。あれえ?

2020年2月14日 (金)

時系列データを扱っていると、たまーに単位根検定をやりたくなることがあるんだけど、Rのパッケージがいろいろあって困る。

仕方がないので、目についたやつについてメモを取った。なんというか、恥をさらしているような気がしますが...

tseriesパッケージ

時系列分析パッケージの古手だと思う。ADF検定, KPSS検定, PP検定の関数を持っている。

adf.test(x, alternative, k): H0「xは単位根を持つ」のADF検定。モデルは定数と線形トレンドを含む。引数は:

- x: 時系列

- alternative: 対立仮説の指定。値は"stationary", "explosive"。後者はnonstatonaryってこと?

- k: ラグ次数。デフォルトではtrunc((length(x)-1)^(1/3))となるそうだ。k=0とするとDickey-Fuller検定になる。

えーっと、いっつも混乱するんだけど、ここで「モデルは定数と線形トレンドを含む」っていうのはどういうことなの?

話を単純にするためにラグ次数を1として、ここで「定数と線形トレンドを含む」といっているのは、差分時系列について

$\Delta y_t = \beta_1 + \beta_2 t + (\phi-1) y_{t-1} + e_t$

というドリフト+トレンドつきモデルを考えて$H_0: \phi = 1$の検定をいたします、ってこと? それとも、元の時系列に切片と1次の項をいれて

$y_t = \mu + \beta_1 t + \phi y_{t-1} + e_t$

$\Delta y_t = \beta_1 + (\phi-1) y_{t-1} + e_t$

つまり差分時系列はドリフトつきモデルです、ってことなの? うぐぐぐぐ。

[02/16 追記: コードをざっと眺めたところ、どうやら前者、つまり$\Delta y_t$のモデルに定数項と1次の項がはいるという話らしい... しらんけど]

kpss.test(x, null, lshort): H0「xはレベル定常ないしトレンド定常である」のKPSS検定。引数は

- x: 単変量時系列

- null: H0はレベル定常かトレンド定常か。値は"Level", "Trend". しっかし、すごい引数名でびびるわ... nullになにかを代入する日が来るとは...

- lshort: 値は論理値。TRUEのとき、truncation lagパラメータが trunc(4+(n/100)^0.25), FALSEのとき trunc(12+(n/100)^0.25) となるのだそうだ。なんだかよくわからん、KPSS検定についてちゃんと勉強しなきゃ。

pp.test(x, alternative, lshort): H0「xは単位根を持つ」のPP検定。定数項と線形トレンドを含む。引数は

- x: 単変量時系列

- alternative: 対立仮説の指定。adf.test()と同じ。

- type: 検定のタイプ。値は"Z(alpha)", "Z(t_alpha)". ううむ、PP検定について不勉強で、なにいってんだかさっぱりわからん。

- lshort: kpss.test()と同じ。

urcaパッケージ.

単位根検定のためのパッケージとして最も有名なのはこれだと思う。

ur.df(y, type, lags, selectlags): ADF検定。引数は

- y: 時系列。

- type: "none"だと切片もトレンドもなし, "drift"だと切片をいれる、"trend"だと切片とトレンドをいれる。これは差分時系列のモデルのことをいってんですよね。

- lags: ラグ次数.

- selectlags. "Fixed"だとなにもしない。"AIC", "BIC"だとlagsに指定した以下の次数をAICなりBICなりで勝手に選んでくれる。

ur.ers(y, type, model, lag.max): Ellot, Rothenberg, & Stock の単位根検定だそうだ。なにそれってかんじだけど、どうやらADF-GLS検定のことらしい。ADF検定より検定力が高いって前に読んだことがあるぞ、理屈はさっぱり理解できなかったけど。引数は

- y: 時系列.

- type: 値は"DF-GLS", "P-test". 後者は誤差項の系列相関を考慮するのだそうだ。へー。

- mode: 値は"constant", "trend". これって元の時系列の話?それとも差分時系列の話?

- lag.max: よくわからんけど、ラグ次数の最大値だそうな。

ur.kpss(y, type, lags, use.lag): KPSS検定. 引数は

- y: 時系列.

- type: 値は"mu", "tau". 前者は切片のみ、後者は切片と線形トレンド。

- lags: 値は"short", "long", "nil"。"short"にするとラグ次数はほにゃらら(メモ省略)、"long"にするとラグ次数はほにゃらら、"nil"にする誤差項の指定なし。

- use.lag: lagsを使わずに、ここで最大ラグ次数を指定してもよい。

ur.pp(x, type, model, lags, use.lag): PP検定。引数は

- x: 時系列.

- type: 値は"Z-alpha", "Z-tau". なんだかわからん。

- model: 値は"constant", "trend".

- lags: 値は"short", "long". マニュアルに説明が書いてない...

- use.lag: lagsを使わずにここで次数を指定してもよい。

ur.sp(y, type, pol.deg, signif): Schmidt & Phillips単位根検定。黒住(2008)ではADF検定ではない「その他の検定」というところで名前だけ出てくる。いわく、ADF検定ってのはWaldタイプの検定なんだけど(なるほど、最尤推定量の差の検定なわけね)、これはラグランジュ乗数検定なんだってさ。そういわれても困るけどな!

引数は

- y: 時系列

- type: 値は"tau", "rho". そういう種類があるんだってさ。しらんがな。

- pol.deg: 多項式の次数だそうだ。値は1,2,3,4。

- signif: 有意水準。値は0.01, 0.05, 0.1.

- y: 時系列

- model: 値は"intercept", "trend", "both". potential breakが切片で起きるか、線形トレンドで起きるか、両方で起きるか。

- lag: ラグ次数の最大値。指定しなくてもいいらしい(えっ、どういうこと?)

forecastパッケージ

泣く子も黙る(?) 有名パッケージ。中の人Hyndman先生は、ただいまこのパッケージのtidyverse対応版であるfableパッケージを鋭意ご製作中らしいのだが、単位根検定関係はまだ移植していない模様。

ndiffs(x, alpha, test, type, max.d, ...): 超お手軽な単位根検定の関数。実はこれ、昨年社外で時系列解析のセミナーやった時にはじめて存在を知り、あまりの簡単さにがっくり膝をついた次第である。だってあれですよ、検定統計量とか一切無視で、単に「何階差分をとるべし」という整数値だけをぽろっと返してくるんですよ。それって、カツカレーくださいって言ったらカツカレーが出てきたようなものじゃないですか...(ちょっとちがうか)

引数は

- x: 時系列

- alpha: 有意水準. 0.01から0.1までの値。

- test: 値は"kpss", "adf", "pp"。

- type: 値は"level", "trend". 恥ずかしながら、これがよく理解できてないんですが... 差分時系列に切片だけはいるか(つまりドリフトつきモデルか)、$t$の1次項もはいるか(つまりトレンドつきモデルか)、ということでしょうか。ってつぶやいてないで、今度ちゃんと調べよう。

- max.d: ラグ次数の最大値。AICかなんかで自動選択してるんだろうなあ。これも今度調べてみよう。

- ...: 単位根検定に渡す引数。たぶんurcaパッケージに渡るんだと思う。

[02/16 追記: 上記の想像通りで、ndiffs()のコードをざっと眺めたところ、ur.df(), ur.kpss(), ur.pp()のいずれかをコールしている模様。次のような対応になっているようだ:

ndiffs(x, test="adf",type="level") → ur.df(x, type="drift")をコール

ndiffs(x, test="adf",type="trend") → ur.df(x, type="trend")をコール

ndiffs(x, test="kpss", type="level") → ur.kpss(x, type = "mu")をコール

ndiffs(x, test="kpss", type="trend") → ur.kpss(x, type="tau")をコール

ndiffs(x, test="pp", type="level") → ur.pp(x, type="Z-tau", model="constant")をコール

ndiffs(x, test="pp", type="trend")→ ur.pp(x, type="Z-tau", model="trend")をコール]

nsdiffs(x, alpha, test, max.D, ...): ndiffs()のSARIMA版、つまり、季節について何階差分をとるべきかを返す。testの値は"seas", "ch", "hegy", "oscb"。おっと、hegyってのがある... uroot::hegy()と同じことなのかなあ...

そのほかのパッケージ

uroot::hegy(x, ...): Hylleberg, Engle, Granger & Yoo の季節単位根検定、だそうだ。勉強不足であれですけど、要するにモデルに季節ダミーが入りますってこと? それとも、SARIMA(p,d,q,P,D,Q)モデルを当てはめるときにDをどうするかってこと? いやまてよ、それって実は同じことなの? うーん、よくわからん。引数はいっぱいあるので省略する。

CADFtest::CADFtest(model, x, type, data, max.lag, min.lag.y, min.lag.X, max.lag.X, dname, criterion, ...): Covariate ADF単位根検定、だそうだ。どうやら、共変量をいれたADF検定らしい。へええ!そんなのあるんだ! ってことはあれですか、時系列変数間で回帰するとき、yが単位根を持っていてもこの検定に通るなら差分取らなくていいよってことっすか? それ助かるわー... J.Stat.Softwareに論文が出てるらしい、今度読んでみよう。

MultipleBubbles::ADF_FL(y, adflag, mflag): ラグ次数を固定したADF検定。adflagがラグ次数、mflagは1のとき切片のみ、2のとき切片とトレンド、3のとき両方なし。これ、関数のヘルプを見る限りふつうのADF検定なんだけど、このパッケージは「バブルの存在をチェックするためのADF検定」のパッケージなので、きっとなんか特別なことをやっているんだろうなあ。

MultipleBubbles::ADF_IC(y, adflag, mflag, IC): 上と同じだが、mflagは最大ラグ次数となり、IC=1とするとAIC, 2とするとBICで次数選択するらしい。

fUnitRootsパッケージ: チューリッヒのThe Rmetrics Accoc.というところが本やRパッケージをたくさん出していて、これもそのひとつ。ADF検定の関数を自前で持っている(unitrootTest(), adfTest())。ほかにurcaパッケージへのラッパーもある。

FinTS::Unitroot(x, trend, medhod, lags): これはTsay(2005)という本のコンパニオン・パッケージ。この関数はfUnitRootsパッケージへのラッパーだそうだ。

aTSAパッケージ: SASとよく似た出力を返す時系列分析パッケージなのだそうだ(ははは)。adf.test(), pp.test(), kpss.test()を持っている。

Rの時系列分析パッケージとしては、ほかにTSAという強力なやつがあるんだけど、単位根検定の関数は持っていないようだ。

2019年11月15日 (金)

用事があって、日帰りで長野の軽井沢というところに行った。有名な避暑地だが、これまでご縁がなく、記憶の限りでは初めての訪問である。

思ったより早く帰れることになったのだが、夕方の軽井沢駅は池袋駅並みにごった返しており、切符の都合で1時間半ほど時間を潰さなければならなくなった。駅の北側に少し歩いて、運よく喫茶店に空席をみつけた。

本でも読もうと思ったんだけど、ウェイターのお兄さんがコーヒーと一緒になにかをテーブルに置き、「時間つぶしにでもどうぞ...」という。それは木製の小さなパズルであった。ボードの上にイラストが描かれた小さなコマがいくつかあり、使い込まれてかすかに茶色い光沢を帯びている。コマを上下左右にずらし、目指す模様をつくるパズルだ。子供の頃にやったことがある。

「ははは」と愛想笑いしたけれど、そんなに暇そうに見えたかなあ、とちょっと気になった。もっともこれは私の気の回しすぎで、他のテーブルのお客さんにも渡していたようである。隣のテーブルの母娘連れも、親戚の悪口などを云いながらひとしきりこのパズルで遊んでいた。

鞄から本を取り出したが、こんな子供だましのパズルも懐かしいものだ、などと思い、頬杖をつき、戯れに指でコマを適当に滑らせてみた。完成したら本でも読もうか、と。

... それから1時間半。読書どころか、ぶっつづけでこのパズルに取り組む羽目になった。

解けない!解けないよ!

このパズル、めちゃくちゃ難しいじゃん!!

時間切れでお店を出るときにはイライラが極限に達しており、レジの横に並べられたこのパズルをひっつかんで買ってしまった。1300円、思わぬ出費である。店主らしき方が笑っていた。

帰りの新幹線でもこのパズルがぐるぐると頭をめぐって離れなかったのだが(「あの4つのリンゴを隣り合わせにして...」云々)、いやまてよ、と我に返った。レジ前の陳列には「日本一難しいパズル」と謳われていた。このパズル、たぶんほんとに難しい奴なのだ。いっぽう、私はあんまし頭の良いほうじゃない。パズルなんて大の苦手だ。なにも私が頑張って解くことはないんじゃないか。

むしろ、パズルを解くプログラムを書いたほうが早いんじゃないか?

問題

買ってきたパズルはこちら。

コマをボードの外に出さずに移動させ、左上のこびとを右下の角に3つの柵でとじこめる、というのがゴールである。

コマをボードの外に出さずに移動させ、左上のこびとを右下の角に3つの柵でとじこめる、というのがゴールである。パズルももちろん著作物であり、勝手にブログに載せてはいけないと思ったのだが、検索してみたところ、喫茶店の方が画像を公開しておられることに気が付いた。これって、喫茶店の店主の方のオリジナル作品なのかしらん? すごいなあ。

お店の名前は「喫茶館丹念亭」。とてもよい雰囲気のお店で、コーヒーもシナモンケーキも美味しかった。いつかまた軽井沢に行く機会があったら立ち寄りたいと思います。

うちに帰ってビールを飲みながら再び試してみて、このパズルにはまった理由がなんとなくわかってきたような気がした。

このパズル、なんとなくコマをすべらせていると、なんとなく盤面が変化する。思いもよらぬ形で大きなコマが動いたときなど、ちょっとした快感がある。しかしよくみると、全く展望が開けていない。同じような局面をぐるぐると回っているだけで、そこから全く脱出できないのである。まるで迷路にはまり込んでしまったような気分だ。

よくわからんが、こういうパズルを考案するのってきっとすごい才能と努力の結晶なのであろうと思う。ほんとに尊敬します。

プログラムで解くにあたっての方針は次の通り。

- Rで書く。この課題にRが向いているからではなくて、単に私がRに慣れているからである。

- このパズルに限らず、このタイプのパズルすべてに適用できるプログラムにする。Wikipediaによれば、こういうパズルのことをスライディング・ブロック・パズル、ないしスライド・パズルと呼ぶらしい。知らなかった。

- 初期状態(つまり、最初のコマの配置)から出発し、そこからコマを動かして到達し得る状態を、力づくですべて探索する。なぜなら、どういう評価関数を書いたらいいのか、私にはよくわからんからである。

- 得られたすべての状態からなるネットワーク・グラフを生成する。パズルの解を求めるコードは書かない。だって、グラフが手に入っていれば、ネットワーク分析のソフトを使えば最短経路を探索できるじゃん?

- 朝までに書き終える。

我ながら頭の悪さがにじみ出る方針である。特に最後の奴がそうだ。結局、翌朝までには書けませんでした。

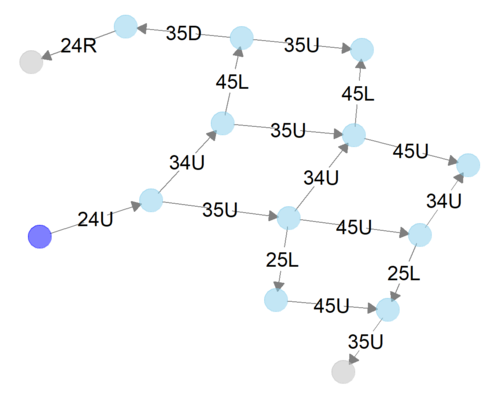

上で状態のネットワーク・グラフと書いたが、これはこういう意図である。

このパズルについていえば、最初にできるのは右上の柵を上に動かすことだけである。2手目にできることは2つある。右端列の下から2番目のリンゴを上に動かす、ないし、右から2つめのリンゴ2個のピースを上に動かしていくことである。3手目にできることは...

... と考えていくと、どんどん枝分かれしていくが、単純に増えていくだけではない。元の状態に戻ったり、別の手順でたどり着いた状態に一致したりすることもありうる。

上図は5手までの状態を表現するネットワーク・グラフである。紫色のノード(円)は初期状態を表している。24Uとは「行2, 列4にあるコマを上に動かす」こと、つまり右上の柵を上に動かすことを意味している。

このように、5手までで14個の状態に到達できるわけだ。到達できる状態の数はどんどん増えていく。これをずーっと続けていけばさ!いつかはゴールに辿りつくよね!

後述するが、こういう過度に楽観的な態度、問題の難しさを最初に客観的に推し量ることを怠る姿勢が、人生の悲劇を招くのである。

これがパズルの解答だ

初期状態から到達し得る状態をすべて調べてみた。ただし、目標条件を満たす状態に辿り着いたら、そこからさらに探索するのはなし、ということにした。つまり、何も考えずにピースを動かしてはいるものの、ゴールに辿り着いたことに気がつかないほどアホではないプレイヤーが、いったいどのような盤面に辿り着きうるか、網羅的に調べたわけである。

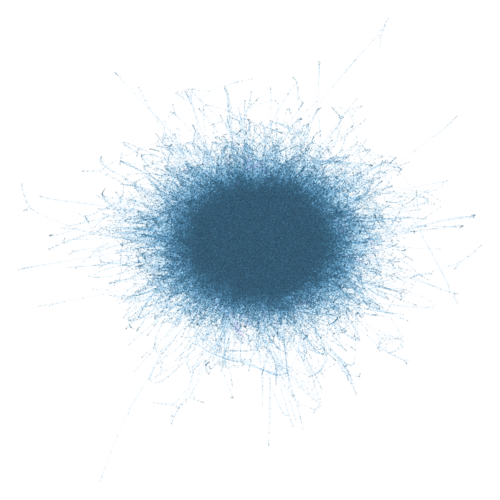

軽井沢で買ったパズルの場合、手元のパソコンで約8時間で探索が終了した。8時間。映画を4本見られる時間、本を数冊読める時間、精力絶倫な王様なら子供をたくさん作れる時間だ。

すべての状態のネットワーク・グラフを描いてみた。それではご覧ください。軽井沢駅北口の喫茶店の店内でパズルのコマを動かしているみなさん! あなたはいま、この図の中のどこかにいますよ!

ネットワーク・グラフどころか、なにか模様のようなものしかみえないが、これはカメラをすごく引いているからで、目を凝らせば見えるであろう微小な点が個々の状態を表している。状態の数は977,412個。うち1個は初期状態、14個はゴールの条件を満たす状態である。

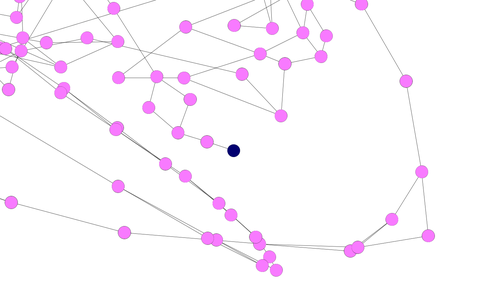

これではあまりに見にくいので、初期状態からゴールまでの経路(正確に言うと、14個のゴールそれぞれへの最短経路)の途中に位置する状態、計3,028個だけを抜き出して描いてみると...

青いノードが初期状態、ピンクのノードが経路上の状態、赤いノードがゴール状態である。

青いノードをお探しですか? 図右側のちょっと下寄りにあります。拡大してみましょう。

要は、この青いノードから辿って行けば、誰でもゴールにたどり着けるわけだ。

ああよかった、これで自分でパズルを解く必要がなくなった。夜もぐっすり眠れるというものだ。

ついでにいうと... 野暮なのでパズルの解答は書きませんけど、このパズルにおけるゴールへの最短経路は217手である。

買ってきたパズルには親切にも模範解答を図示した紙が添付されているのだが、その手数は254手(181手と記載されているが、ここではひとつのコマの1マスの移動を1手と数える)。おかげさまで、模範解答よりもすこし手数の少ない解答を見つけたことになる。ほんの少しだけ達成感があるが、いやいやそれよか、パズルを考案する人のほうがずっとすごいですよね。

だからどうした

だからどうしたんだこの暇人め、といわれると困ってしまうのだが、今回は自分なりにいろいろ学ぶところ大きかった。

帰りの新幹線のなかでぼんやり思ったのは、どうせ盤面の状態は限られているだろう、ということであった。盤面の大きさは4x5マス、コマの数は10個。喫茶店内でコマをあれこれ動かしているときも、なんだか同じ状態を行きつ戻りつしているような気がしてならなかった。だったら私にも全探索できちゃうんじゃない?と思ったのである。

振り返るとこれは無謀な賭けであった。組み合わせの数の大きさというものは人間の直感を遥かに超える。今回のパズルはたまたま初期状態から到達できる状態の全探索が可能であったし、あとで試算したところでは、そもそもこのパズルで可能な状態の数は1,281,550個しかない。しかし、問題が少し異なるだけで、状態の数は爆発的に増大し、まともな時間では到底全探索できないものとなっていただろう。

なんについてもいえることなんだろうけど、最初に問題の大きさを推し量ることって、すごく大事ですね。どうもそういう姿勢が私には欠けているようだ。反省。

なぜ難しいのか

それにしても不思議なのは、このパズルがなぜこんなに難しいのかという点である。実際に遊んだことがない方に、解のネタバレを避けつつ説明するのはすごく難しいんですが、とにかくほんとに難しいんですってば。イライラするんですってば。

難しい理由のひとつは、もちろん、ゴールまでの手順の多さであろう。しかしそれだけが要因ではないという気がしてならない。なんというか、いくらコマを動かしても、同じような局面をぐるぐると回っているように感じられるのである。

こうした難しさを、ネットワーク・グラフの形状によって定量的に示すことはできないだろうか。

同じような局面からなかなか脱出できないということは、ネットワーク・グラフのあちこちにノードの密な固まりがあって、その固まりから外に出て行くエッジが少ない、ということだろう。とすれば、ネットワーク・グラフ全体を通じてノードが局所的に固まっている程度を測ればよいのではないか。このパズルでは、その値がとても高くなっているのではないか?

思い悩んだ末、次のようなことを試してみた。

あるネットワーク・グラフについて、ノードをいくつかのグループにわけたとする。ネットワーク分析の慣例に従い、これをコミュニティと呼ぶことにする。

ノードの間のエッジは、同一コミュニティ内でつながるエッジと、コミュニティをまたがるエッジとにわかれる。前者のエッジの比率が大きいとき、コミュニティはネットワークのなかの密度の高い固まりをうまく捉えていることになる。

そこで、コミュニティ内のエッジの比率が、「そのグラフのエッジを一旦すべて消し、かわりに同じ数のエッジをランダムに張ったときに得られる、コミュニティ内のエッジの比率」と比べてどれだけ大きいかを調べる。これをモジュラリティという。うーん、下手な説明だが、要するに、モジュラリティが大きいことは、ノードがコミュニティの中で高密度に固まっていることを示しているわけである。

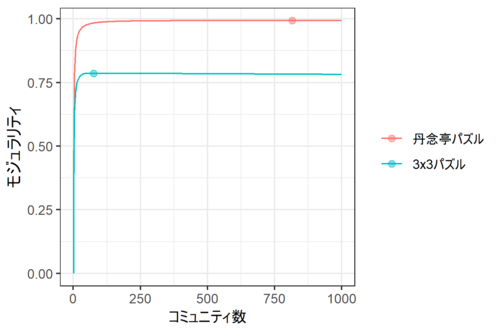

上のアイデアに従い、丹念亭パズルのネットワーク・グラフを徐々にたくさんのコミュニティに分割していき、そのたびにモジュラリティを測ってみよう。

どうやってコミュニティに分割するか。いろんな方法があるんだけど、ここでは手っ取り早く、Clausetたちの手法を使うことにする。これ、計算がすごく速いんです。

比較のために、すごくシンプルなスライドパズルについても同じことを試してみる。盤面は3x3, コマは8つ、サイズはすべて1x1であるパズルを考える。つまり、下図を3x3に縮めたようなパズルです。

このパズルについて、初期状態から辿り着くことができるすべての状態(181,440個)のネットワーク・グラフを作った。で、こちらについてもコミュニティ数を増やしながらモジュラリティを調べた。

結果は下図の通り。

丹念亭のパズルではコミュニティ数816、3x3のパズルではコミュニティ数76のとき、モジュラリティが最大になった。

ここで注目したいのはモジュラリティの違いである。丹念亭パズルのモジュラリティは最大で0.993と、法外に高い。つまり、ネットワーク・グラフの描画からは読み取れないが、あたかも少量の水に溶かした小麦粉のダマのように、ノードが小さくて密度の高い固まりを形成しているのではないかと思う。そのため、やみくもにコマを動かしても、その固まりの外側になかなか出られない... ということではないかしらん?

疑問点

... などと書いてはみたものの、正直なところ、あまり自信がない。

- 3x3パズルは丹念亭のパズルよりも状態数が小さいし(9!=362880通り)、ネットワーク・グラフの作成にあたって目標状態を設定せずに全探索しているので、適切な比較になっているかどうかわからない。

- Clausetたちの手法は凝集的なコミュニティ検出手法なので、所与のコミュニティ数についてモジュラリティ最大のコミュニティを検出していないかもしれない。

- なにより、ここでモジュラリティに注目したのは良いやり方だったのだろうか。ネットワークがクラスタ化している程度を調べる際にはクラスタ係数と呼ばれる指標を使うことが多いと思うんだけど、スライド・パズルの状態のネットワーク・グラフはクリークを持たないので(3手で元に戻ることはできないから)、クラスタ係数は0となる。こういうネットワークについて、それがクラスタ化されている程度を調べるためにはどうしたらいいんだろう?

ううむ... このへんで時間切れということにしておくけど、いろいろ勉強が足りないことがわかった。

rSlidePzlパッケージ

軽井沢駅前の喫茶店でパズルを渡された副産物として、任意のスライド・パズルについて初期状態から到達しうる状態を全探索しネットワーク・グラフを生成するRパッケージ rSlidePzl を作りました。

ああ、私には聞こえる。任意のスライド・パズルについて初期状態から到達しうる状態を全探索しネットワーク・グラフを生成したいと思っている、世界三千万人の善人男女の歓喜の叫びが。(嘘です聞こえません)

パッケージはgithubからインストールできる。

このパッケージを使えば、お手元のスライド・パズル(9x9マス以内)について、初期状態から到達し得る状態をすべて探索し(幅優先探索)、みつかった状態からなるネットワーク・グラフをつくることができる。

せっかくなので、初期状態からゴールへの最短手順を出力する関数もつくっておいた。また、得られたネットワーク・グラフを(それが小さめであれば)簡単に描画できる関数もつくった。

探索すべきすべての状態を探索し尽くす場合、とんでもなく時間がかかることを覚悟する必要がある。これを避けるため、探索する手の深さ(何手目まで探索するか)や、探索する状態の総数について上限を指定し、探索を途中で打ち切ることもできる。

このパッケージを使って得られるネットワーク・グラフは igraph パッケージの igraph クラスのオブジェクトである。igraph パッケージが提供する多様な関数によって、その性質を心ゆくまで調べることができる。

コード例を示す。

### devtoolパッケージをインストール

### install.packages("devtools")### rSlikePzlパッケージをインストール

# devtools::install_github("shigono/rSlidePzl")### rSlikePzlパッケージをロード

library(rSlidePzl)library(tidyverse)

library(igraph)### セッティング

oSetting <- makeSetting(

## 盤面のサイズ (行サイズ, 列サイズ)

boardsize = c(4,5),

## コマのサイズ (行サイズ, 列サイズ)

piecesize = list(

A = c(2, 2), # コマタイプA.こども パズルに添付されている解答ではNo.1

B = c(2, 1), # コマタイプB.りんごとサク No.5

C = c(1, 2), # コマタイプC.横長のサク No.7

D = c(1, 1), # コマタイプD.りんご, No.2,3,9,10

E = c(2, 1), # コマタイプE.縦長のサク, No.6

F = c(2, 1), # コマタイプF.縦長のりんご No.8

G = c(1, 2) # コマタイプG.横長の林檎 No.4

)

)### こどものピースの位置(1,1), (1,2), (2,1), (2,2)について考える

anNumStates <- sapply(

list(c(1,1), c(1,2), c(2,1), c(2,2)),

function(anLoc){

### 可能な状態の数を算出する

getNumStates(

makeState(

list(

makePiece(type = "A", loc = anLoc),

makePiece(type = "B", loc = c(NA,NA)),

makePiece(type = "C", loc = c(NA,NA)),

makePiece(type = "E", loc = c(NA,NA)),

makePiece(type = "F", loc = c(NA,NA)),

makePiece(type = "G", loc = c(NA,NA))

)

),

oSetting

)

}

)

# - こどものピースが位置(1,1)(左上端)であるときの状態数は、

# 左下端(3,1), 右上端(1,4), 右下端(3,4)にあるときの状態数と同じはずなので、4倍する

# - こどものピースが位置(1,2) にあるときの状態数は、

# (1,3), (3,2), (3,3) にあるときの状態数と同じはずなので、4倍する

# - こどものピースが位置(2,1) にあるときの状態数は、

# (2,4) にあるときの状態数と同じはずなので、2倍する

# - こどものピースが位置(2,2) にあるときの状態数は、

# (2,3) にあるときの状態数と同じはずなので、2倍する

# 各状態においてりんごのピースを置く位置は6 x 5 / 2 通りあるから...

print(sum(anNumStates * c(4,4,2,2)) * 6 * 5 / 2) # 状態数は1281550### 開始時点の盤面の作成

oStart <- makeState(

list(

makePiece(type = "A", loc = c(1,1)), # パズルに添付されている解答ではNo.1

makePiece(type = "B", loc = c(1,3)), # No.5

makePiece(type = "C", loc = c(2,4)), # No.4

makePiece(type = "D", loc = c(3,1)), # No.2

makePiece(type = "D", loc = c(3,2)), # No.3

makePiece(type = "E", loc = c(3,3)), # No.6

makePiece(type = "F", loc = c(3,4)), # No.8

makePiece(type = "D", loc = c(3,5)), # No.9

makePiece(type = "G", loc = c(4,1)), # No.4

makePiece(type = "D", loc = c(4,5)) # No.10

)

)

stopifnot(isValidState(oStart, oSetting))### 目標条件の作成

oGoalCondition <- makeState(

list(

makePiece(type = "A", loc = c(3,4)), # No.1

makePiece(type = "B", loc = c(1,3)), # No.5

makePiece(type = "E", loc = c(3,3)), # No.6

makePiece(type = "C", loc = c(2,4)) # No.7

)

)

stopifnot(isValidState(oGoalCondition, oSetting))### 5手だけ検索

oGraph <- makeGraph(oSetting, oStart, oGoalCondition, verbose = 1, max_depth = 5)### 描画

set.seed(123)

plotGraph(oGraph, method = "GGally")### すべての手順を探索。手元のパソコンで8時間くらい

oGraph <- makeGraph(oSetting, oStart, oGoalCondition, verbose = 1)### 目標条件を満たした状態を表示

print(V(oGraph)[V(oGraph)$status == 4])### 目標条件を満たした状態への最短経路を表示

print(getShortestPath(oGraph)$transition)### コミュニティ検出。fast_greedy法でmodularityを最適化する

oGraph_undirected <- as.undirected(oGraph)

oCommunity <- cluster_fast_greedy(oGraph_undirected, modularity = TRUE)### 描画。Rでは大変なのでGephi (https://gephi.org/) で描く。

### グラフに描画のための属性を追加する

### state_color属性: {1(初期状態),2(目標状態),3(目標への途中),4(ほか)}

### Gephiでこの属性をcolorに指定すると、ノードを色分けできる

anColor <- rep(4, length(V(oGraph))) # 4: 下記以外の状態

anColor[getReachability(oGraph) == 1] <- 3 # 3: 目標状態に至るパス上にある状態

anColor[V(oGraph)[V(oGraph)$status == 4]] <- 2 # 2: 目標状態

anColor[1] <- 1 # 1: 初期状態

V(oGraph)$state_color <- anColor### state_size属性: {1(目標への経路上にない),2(ある)}

### Gephiでこの属性をsizeに指定すると、目標への経路上のノードを大きくできる

V(oGraph)$state_size <- c(2,2,2,1)[anColor]

V(oGraph)$state_comm <- membership(oCommunity)### state_x属性, state_y属性: x座標とy座標

### GephiのGeo layoutでこれらの属性を緯度経度に指定すると、レイアウトを再現できる。

### コミュニティ内のエッジに大きな重みを与え、Fruchterman-Reingoldアルゴリズムで

### 最適化している。Gephiでレイアウトを作成してもいいけど、こっちのほうが速い

oLayout <- layout_with_fr(

oGraph,

weights = ifelse(crossing(oCommunity, oGraph), 1, 10),

niter = 1000

)

### 座標が大きな値だとメルカトル図法では歪んでしまうので、-1から+1に基準化する

oLayout <- norm_coords(oLayout)

V(oGraph)$state_x <- oLayout[,1]

V(oGraph)$state_y <- oLayout[,2]### graphml形式で出力。このファイルをGephiで読み込む

write.graph(oGraph, file = paste0("./full_states.graphml"), format = "graphml")### 3x3パズルのセッティング

oSetting <- makeSetting(

boardsize = c(3,3),

piecesize = list(

A = c(1, 1), B = c(1, 1), C = c(1, 1), D = c(1, 1),

E = c(1, 1), F = c(1, 1), G = c(1, 1), H = c(1, 1)

)

)

oStart <- makeState(

list(

makePiece(type = "A", loc = c(1,1)),

makePiece(type = "B", loc = c(1,2)),

makePiece(type = "C", loc = c(1,3)),

makePiece(type = "D", loc = c(2,1)),

makePiece(type = "E", loc = c(2,2)),

makePiece(type = "F", loc = c(2,3)),

makePiece(type = "G", loc = c(3,1)),

makePiece(type = "H", loc = c(3,2))

)

)

stopifnot(isValidState(oStart, oSetting))### 3x3パズルのネットワーク・グラフ作成

oGraph_Nine <- makeGraph(oSetting, oStart)### 上と同じやり方でコミュニティ検出

oCommunity_Nine <- cluster_fast_greedy(as.undirected(oGraph_Nine), modularity = TRUE)### モジュラリティ比較

oGraph_undirected <- as.undirected(oGraph)

anModularity <- sapply(

1:1000,

function(nNum){

modularity(oGraph_undirected, cut_at(oCommunity, no = nNum))

}

)

oGraph_undirected <- as.undirected(oGraph_Nine)

anModularity_Nine <- sapply(

1:1000,

function(nNum){

modularity(oGraph_undirected, cut_at(oCommunity_Nine, no = nNum))

}

)

dfPlot <- data.frame(

nNumComm = 1:1000,

nMod_1 = anModularity,

nMod_2 = anModularity_Nine

) %>%

gather(sVar, gValue, c(nMod_1, nMod_2)) %>%

separate(sVar, c("sVar1", "nVar2")) %>%

group_by(nVar2) %>%

mutate(bMax = if_else(gValue == max(gValue), 1, 0)) %>%

ungroup() %>%

mutate(fGraph = factor(nVar2, levels = c("1", "2"), labels = c("丹念亭パズル", "3x3パズル")))

g <- ggplot(data = dfPlot, aes(x = nNumComm, y = gValue, color = fGraph))

g <- g + geom_line()

g <- g + geom_point(data = dfPlot %>% filter(bMax == 1), size = 2, alpha = 0.5)

g <- g + labs(x = "コミュニティ数", y = "モジュラリティ")

g <- g + scale_color_discrete(name = NULL)

g <- g + theme_bw()

print(g)### 以上

githubを使うのも、Rパッケージを公開するのもはじめてなので、いろいろ不備があるかもしれませんが、そのへんはひとつ、ご愛敬ということで...

軽井沢駅前の喫茶店の店員さんに渡されたパズルを解く (ためのRパッケージを作った)

2019年11月13日 (水)

ここんところこういう覚え書きばかりで、自分でも嫌になっちゃうんだけど...

無向グラフにおいて、ノードiとj, jとkの間にエッジがあるときに、iとkの間にもエッジがあることを推移的であるという。有向グラフでは、iからj, jからkへのエッジがあるときに、iからkへのエッジもあることを推移的であるという。

あるグラフにおいて、推移的であるかもしれない2つのノード(上でいうiとk)が実際に推移的である割合を推移性 transitivity という。えーと、Newman, Watts & Strogatz(2002)が提案したのだそうだ。

Rのigraphパッケージでいうと、transivity(g, type ="global") で無向グラフの推移性を求めることができる。なお、transitivity()は有向グラフも無向グラフとして扱うようだ。エッジの向きを考慮したいんなら自分で求めろ、ってことでしょうか。

あるノードからみて、それと隣接するノードからなるサブグラフを考え、その密度(つまり、ありうるエッジの数に占める実際のエッジの数の割合)を求める。これをそのノードのクラスタ係数 clustering coefficient と呼ぶ。igraphパッケージではtransivity(g, type = "local")で求めることができる。

あるグラフについてノードのクラスタ係数を平均した値を、グラフのクラスタ係数という。igraphパッケージではtransivity(g, type = "average")で求めることができる。

このクラスタ係数というのはWatts & Strogatz (1998)が提案したのだそうだ。どっちもワッツさんたちである。なんだかなあ。

推移性とグラフのクラスタ係数はよく似ているんだけど、ちょっと異なる。

いったいどう異なるのか。なにがなんだかわかんなくなってイライラしてきたので、仕事を中断してメモを取った。

準備。

無向単純グラフ$G = (V,E)$について考える。つまり、エッジに向きはないし、自己ループもないし、2ノード間には辺があるかないかのどっちかで、エッジに重みなどというややこしいものはない。

ノード$v$に隣接するノード数を次数$d(v)$とする。

$G$の3つのノードからなる完全サブグラフを三角形と呼ぶ。ノード$v$を含む三角形の数を$\delta(v)$とする。グラフ全体について考える場合、ひとつ三角形が増えるだけで$\delta(v)$の合計は3増えるから、グラフ全体の指標としては

$\delta(G) = \frac{1}{3} \sum_{v \in V} \delta(v)$

がふさわしい。

ノード$v$を中間に持つ長さ2のパスを$v$のトリプルと呼ぶ。その数を$\tau(v)$とすると、$n$個から$k$個を取り出す組み合わせを$combn(n, k)$と書くならば$\tau(v) = combn(d(v), 2)$だ。合計すると

$\tau(G) = \sum_{v \in V} \tau(v)$

本題に戻ろう。

推移性とはなにか。それはトリプルの総数に占める三角形の総数だから、

$\displaystyle T(G) = \frac{3\delta(G)}{\tau(G)}$

である。

グラフのクラスタ係数とはなにか。

次数$d(v) \geq 2$のノードについて、ノードのクラスタ係数$c(v)$とは、トリプルの数に占める三角形の数、つまり$c(v) = \delta(v)/\tau(v)$である。グラフのクラスタ係数というのはこれを平均した値だから、次数2以上のノードの集合を$V'$として

$\displaystyle C(G) = \frac{1}{|V'|} \sum_{v \in V'} c(v)$

である。

なお、次数が1までのノードについてもなんらかクラスタ係数を決め(0だか1だか)、単純平均してしまうという方法もある。

ここで加重クラスタ係数というのを考えてみる。各ノードにウェイトとして正の実数$w(v)$が振られているとしよう。グラフの加重クラスタ係数を

$\displaystyle C_w(G) = \frac{1}{\sum_{v \in V'} w(v)} \sum_{v \in V'} w(v) c(v)$

とする。

仮に、トリプルの数をウェイトにしたら、つまり$w(v) = \tau(v)$としたらどうなるか。$c(v) = \delta(v)/\tau(v)$より、総和記号の右の$\tau(v)$は消えて、

$\displaystyle C_\tau(G) = \frac{\sum_{v \in V'} \delta(v)}{\sum_{v \in V'} \tau(v)} = T(G)$

となる。

つまり推移性とは、各ノードが持つトリプルの数を重みにした加重クラスタ係数のことだ。全ノードの次数が同じとき、ないし全ノードのクラスタ係数が一致しているとき、グラフのクラスタ係数と推移性は等しくなる。

以上、次の論文のイントロ部分よりメモ。

Shank, T., Wagner, D. (2005) Approximating clustering coefficent and transitivity. Journal of Graph Algorithms and Applications. 9(2), 265-275.

なるほどね...

グラフの特性を記述する際、推移性を使うべきなのだろうか、グラフのクラスタ係数を使うべきなのだろうか。たとえばある社会が「友達の友達もまた友達だ」的性質を持っているかどうかを調べるならば、ノードをベースに考えて後者を使い、たくさんの離散的状態を遷移していくなにかについて、そこでの遷移が「3期後には元に戻っちゃう」的性質を持っているかどうかを調べるならば、エッジをベースに考えて前者を使う、ということかなあ...

ちょっとした覚え書き:グラフの推移性とクラスタ係数はどうちがうか

2019年11月 8日 (金)

最近なんだかこんなことばっかりなんだけど...

Rで環境 (environment) と呼ばれるオブジェクトを操作したいとき、関数名がよく分からなくて困ることが多い。rlangパッケージというのを使うと、もっと使いやすい関数がわかりやすい名前で提供されていてありがたいんだけど、従来の関数との対応がわからなくて、それはそれで混乱する。

このたびついに業を煮やして、神Hadleyが与えたもうたAdvanced R 2nd edition, Chapter 7. Environments を参照しつつメモを取った。

すいません、私の私による私のためのメモです。

環境そのものの操作

- 環境をつくる: rlang::env(); new.env()

- 環境 e を表示する: rlang::env_print(e), print(e). ただしprint()では中身はわからない

- 環境 e の親環境: rlang::env_parent(e), parent.env(e)

- 環境 e のすべての先祖の環境: rlang::env_parents(e)

- 空の環境(すべての環境の始祖): rlang::enpty_env()

- グローバル環境(いわゆるワークスペース): rlang::globalenv(), .GlobalEnv

- サーチパス(グローバル環境の先祖の環境たち)の名前を返す: search()

- サーチパスの環境たちを返す: rlang::search_envs()

- baseパッケージのパッケージ環境 (そのパッケージが外部に提供する環境): rlang::base_env()

- 現在の実行環境(関数の実行中はその関数の実行環境、そうでない場合はグローバル環境): rlang::current_env(), environment()

- 現在の関数を呼び出している関数の実行環境: rlang::caller_env(), parent.frame()

- ある関数が実行されるときに生まれる実行環境の親は、その関数の「関数環境」である(呼び出し元の関数の実行環境ではない。ここ、ときどき勘違いしちゃいますね)。関数環境とは、その関数がつくられたときにそいつがbindしたというかキャプチャした環境のこと。対話的につくった関数の関数環境はグローバル環境、関数1のなかでつくった関数2の関数環境は関数1の実行環境となる。

- 関数 fの関数環境: rlang::fn_env(f), environment(f)

- パッケージのなかの関数の関数環境はそのパッケージの名前空間環境。その親はそのパッケージのimports環境。その親はbaseパッケージの名前空間環境。その親はグローバル環境。

環境の中身の操作

- 環境 e のなかの名前をみる: rlang::env_names(e), names(e), ls(e, all.names = T)

- 環境 e が要素 x を持っているかを調べる: rlang::env_has(e, "x"), exists("x", e)

- 環境 e の要素 x にアクセスする: e$x, e[["x"]]

- 環境 e の要素 x の値を得る(存在しないときにはエラーを発生させる): rlang::env_get(e, "x"), get("x", e, inherits = FALSE)

- 環境 e の要素 x に値 1 をbindする: rlang::env_poke(e, "x", 1), rlang::env_bind(e, x = 1); assign("x", 1, e).

- 環境 e の要素 x に表現myfun()をbindするが、そのときは評価せず、最初にアクセスしたときだけ評価する: rlang::env_bind_lazy(e, x = myfun()), delayedAssign("x", myfun(), assign.env = e)

- 環境 e の要素 x に関数myfunをbindする。アクセスするたびに評価する: rlang::env_bind_active(e, x = myfun), makeActiveBinding("x", myfun, e)

- 環境 e の要素 x を消す: rlang::env_unbind(e, "x"), rm("x", envir = e)。なお、e$x <- NULL では消せない。

- 永続付値 <<- は、先祖の環境たちのどこかにある変数を変更する。どこにもみつからなかったらグローバル環境に変数をつくる。現在の環境にある変数を変更したり、変数をつくったりすることはない

2019年10月29日 (火)

話はちがうが(なにからだ)、Stanを使っていると、ときどきデータ型について混乱してしまうことがある。数日前も同僚が書いたコードをみていて、しばしわけがわからなくなってしまった。私が悪いんです、すいません。

松浦「StanとRでベイズ統計モデリング」の9章を熟読すればよい問題なのだが(自宅にも職場にも置いてあるんだし)、毎度毎度めくっているのもどうかという気がしてきたので、Users Guide (2.19)の15-16章を眺めてメモを取った。

15. Matrices, Vectors, and Arrays

- Stanのデータ型は、int, real, vector, row_vector, matrixの5つ。

- どの型も配列にできる。たとえばreal b[M,N]は2次元の配列。

- サイズを動的に変えることはできない。

- 2次元配列と行列を比べると、行列のほうがメモリがちょっと小さい。行列はメモリ上で固まってストアされているが配列はそうでない。

- 行列は列優先順でストアされているので、matrix[M,N] aならさきに1:Nでループしたほうが速い。配列は行優先順ではいっているので、real b[M,N] ならさきに1:Mでループしたほうが速い。そして行列のほうが速い。

- matrix[M,N] aに対して a[m] を呼ぶと行ベクトルが返るけど、これは遅い。row_vector[N] b[M]に対して b[m]を呼んだほうが速い。

- 行列の行列演算は速い。

- コンテナとしてみたとき、vector, row_vector, スカラーの一次元配列は同じ(ただし整数が入れられるのは配列だけだけど)。

16. Multiple Indexing and Range Indexing

- たとえば int c[3] に(5,9,7)をいれといて、ind indx[4]に(3,3,1,2)をいれとくと、c[idxs]は(7,7,5,9)を返す。こういうのがmultiple indexing。

- その特殊ケースとしてrange indexing (slicing)がある。c[1:2]とかね。c[2:size(c)]ってのもあり。c[:2]はc[1:2]の略記になる。c[]とc[:]は同じ。

16章にはほかにもいろいろ書いてあるんだけど、なんだかめんどくさくなってきたので、まあいいや、別の機会にしよう。

2019年8月14日 (水)

昔取ったメモのなかからR言語の自作チートシートが出てきた。2011年4月、転職をきっかけにしてRを使わなければらない羽目になり、何冊かの参考書をめくりながらとったノートである。当時はRについて全くの初心者で、右も左もわからない状態であった。

その後数か月間は折に触れて眺めては、新たに気が付いたことを追記・更新したと思うけれど、いずれ参照しなくなり、すっかり忘れ去っていた。チートシートというのはそういうものであろう。

それから8年の月日が流れ (自分で書いててショック)、いま見返してみると、いまではごく当然に思えることに新鮮な驚きを感じている形跡があったり、いまでは全く使わなくなった関数について真剣に調べていたり、それまで日々使っていたSAS言語といちいち比べていたり... なんというか、感慨深い。ああ、あのころ私は若かった... (嘘です。当時からおっさんでした)

せっかくなので、ちょっと整形してブログに載せ、供養としたい。

式

- 数値演算子は ^(ないし**), *, /, +, -, %/%(整数除算), %%(剰余)

- 演算子の優先順位がわからなくなったら

?Syntaxをみる - 代入記号として

<-が推奨されている - 代入式を評価すると、左辺の代入後の値が戻る

- オブジェクト名はcase sensitive

- ピリオドから始まるオブジェクトはhiddenとなる

データ型

- atomicなデータ型は5つ: {NULL, logical, numeric, complex, character}

- numericはメモリ上ではintegerだったりdoubleだったりする

is.character()etc. で型を確認as.character()etc. で型キャスト

データ構造

- 主なデータ構造は{vector, matrix, array, list, data frame}

- scalarという構造はない。要素1のvectorとして表現する

str()で構造とか中身の要約とかを表示- vector: ベクトル

- 要素は任意のデータ型

- ただし、あるベクトルの中の要素はすべて同じデータ型でなければならない。無理に突っ込むと一番上位の型に強制変換される

- 生成方法:

-

c()で要素を結合して生成 numeric(length=3)etc. でいきなり生成1:3ないしseq(3)でベクトル(1,2,3)を生成rep(2:4, 1:3)でベクトル((2),(3,3),(4,4,4))を生成

-

- 生成時の注意点

c()やnumeric()でいきなり数値をいれた場合、メモリ上では double になる (Matroff本p.54)。ゆえにc(1,2,3) != 1:3- コロン演算子 「:」 の挙動に注意 (Matroff本p.33)。

x==0のとき、1:xはc(1,0)になってしまう。正方向にのみ動かしたかったらseq()を使うべし。ただし、is.null(x)のとき1:xは NULL になるので都合がよいという面もある

length()が長さを返す- ベクトルの加減乗除が可能。要素ごとに計算される。長さが違うときは短いほうが繰り返される。例:

t(2:4) %*% 1:3ないしcrossprod(2:4,1:3)が内積20を返す x[3]がベクトルxの3番目の要素(からなるベクトル)を表す。添え字はベクトルでもよいx[-3]はベクトルxの「3番目の要素を除く全要素」のベクトルを表すx == c(1,3,5)のとき、x>4はベクトル(FALSE, FALSE, TRUE)を返すので、x[x>4]はベクトル(5)を表す- このとき、

which(x>4)はベクトル(3)を返す。3番目の要素がヒットしたという意味 x[] <- 2は xの全要素を2に置き換える (x <- 2との違いに注意)- 要素に名前をつけることができる。例)

x <- c(itemA = 1, itemB=2)。x["itemA"]が1を返す (perlのハッシュのような感じで使えるようだ)

- 次元つきのvector (←ベクトルの特殊な場合と考える。面白いなあ)

matrix(1:6, ncol=3)というようにして生成。→ 1列目が(1,2)になるX <- c(1:6); dim(X) <- c(2,3)でも同じall(X == Y)という風に比較dim(), ncol(), nrow()が次元数、列数、行数を返すrow(), col()は同じサイズの行列を返す。その要素は行番号ないし列番号で埋まっているX[i,j]が要素を表すX[i,]が行ベクトル、X[,j]が列ベクトルを表す (気持ち悪い...)- 上の記法でアクセスすると、返ってくるのはmatrixかもしれないしvectorかもしれない。

X[1,1,drop=FALSE]とするとXと同じ次元数のmatrixを返す - 添え字は行列でもよい。これを利用して、(行番号、列番号、値) を行としてもつ行列から表をつくることができる(cf. スペクター本のp.97)

diag(X)は対角要素のベクトルを表す

- 任意の数の次元を持つ

array(1:12, dim=c(2,3,2))というようにして生成

- 要素として異なる型のデータ構造を含みうる

list()で要素を結合して生成L[3]はリストLの3番目の要素からなるリストを返す。添え字はベクトルでもよいL[[3]]がリストLの3番目の要素そのものを表す。それがどんな型のデータ構造かはわからない- 二重括弧添字をベクトルにすると再帰的な指定になる。例)

L <- list(1:3, c("Hello", "World"))のとき、L[[c(2,1)]]とL[[2]][1]は等しい ("Hello") - 要素の名前を付けることができる。例)

L <- list(Start = 1, End = 2)。L[["Start"]]が 1 を返す。これをL$Startと略記できる

- データセットを表す特殊なリスト

- 要素は同じ長さのベクトル。つまり、Rではデータセットを行構造体のベクトルとしてではなく、列ベクトルの集合として扱うわけだ

data.frame()で要素(データセットの列ベクトル)を結合して生成- 文字は勝手にfactorにされてしまう。嫌なら

stringsAsFactors=TRUEをつける - 要素の名前をつけることができる。例)

purchase <- data.frame( product = c("a", "b")) $略記も使える。例)purchase$product[2] == "b"- [行番号、列番号] と添え字をつけてアクセスできる。

purchase[2,1] == "b" attach()すると変数名を直接呼べるようになる。detach()で解放される。attach()はデータフレームの中身を新しい環境にコピーしている。元のオブジェクトを書き換える際には、attach()していようがいいがデータフレーム名から呼ぶこと。attach()はまちがいのもと、つかわないほうがよい- カテゴリカル変数はfactor型として表現される。factorはatomicな型ではなく、

factor()で生成されるオブジェクト

リストの操作

stack(): リスト要素がすべてベクトルであるとき、それをすべて縦に結合した列と、タグ名を縦に結合した列の2列からなるデータフレームをつくる。例)stack(list(x=1:3, y=4:6, z=7:9))

データフレームの操作

- データフレームの例:

purchase <- data.frame(

product = c("apple", "cheese", "yogurt", "ham", "water"),

shop = c("drink", "daily", "daily", "meat", "drink"),

amount = c(2,3,1,5,6)

) - ソート:

order()は順位ベクトルを返すので、purchase[order(purchase$amount) , ]でソートしたことになる (なるほどー) - 行抽出(SASでいうサブセットif)

purchase[["shop"]] == "daily"はベクトル(FALSE, TRUE, TRUE, FALSE, FALSE)を返すから、purchase[purchase[["shop"]] == "daily" , ]とすればよいsubset(purchase, shop == "daily")でもよい。subset()は条件がNAになったときにfalse扱いしてくれる%in%演算子をつかってベクトルと比較してもよい。subset(purchase, shop %in% c("daily","meat"))

- 分割 (SASでいう when ... output ...):

LD <- split(purchase, purchase$shop)。LDは3つのデータフレームからなるリストになる。要素はLD$drink, LD$daily, LD$meatとなる - 縦に結合 (SASでいうset A B):

rbind(LD$drink, LD$daily) - 横に結合 (SASでいう byなしのmerge):

cbind(1:3,11:13)。ただし長さが同じでないといけない - マッチマージ (SASでいうby文つきのmerge):

merge(X, Y [, オプション])- マッチキーの指定

- 指定しないと名前が共通する列すべてがマッチキーになる (SQLでいう natural join)

by=(ベクトル)... マッチキーを指定するby.X=(ベクトル), by.Y=(ベクトル)... データフレーム別にマッチキーを指定する- 長さ0のベクトルを指定するとデカルト積になる(SQLの cross join)

- マッチキーによる事前のソートは不要 (そりゃ助かるね)

- マージの種類の指定

all = FALSE... マッチした行だけ (SQLの inner join)all.X = TRUE... Xは全行、Yはマッチした行だけ (SQLの left join)all.Y = TRUE... Xはマッチした行だけ、Yは全行 (SQLの right join)all = TRUE... マッチしようがしまいが全行 (SQLの full join)

データの集約(スペクター本の8章)

table(X)- Xはベクトル、リスト、データフレーム

Xにはいっているユニークな行ごとに、その行数を数えるXに入っているベクトルの数の次元数の配列を返す。例, 3本なら3次元配列- 各次元には名前がつく。それはデータベクトルに出現する水準

exclude=NULL引数で欠損値を含むことができるas.data.frame()に渡すと便利addmargins()に渡すと、各次元につきSum行を追加してくれるprop.table()に渡すと、割合の表に変換してくれる

xtabs(formula, data=X): formulaの左辺はなし、ないし頻度ウェイトftable(X)※本項は間瀬本p.181Xはふつうtable()なりxtabs()なりの出力Xを二次元の表にして返すrow.vars = 1:3で、1,2,3次元が表側、残りが表頭になるwrite.ftable()に渡すときれいなascii形式にしてくれる。いいんだかわるいんだか

- 集約のためのヒント

- グループがすでにリストの要素に分けられている → sapply, lapply

- グループが行列の行or列である → apply

- グループが一つ以上のグループ化変数で示されている

- 操作対象が単一のベクトル

- 結果はグループごとのスカラー → aggregate

- 結果はベクトル → tapply

- 操作対象が複数のベクトル → tapply, by

- 操作対象が単一のベクトル

lapply(X, FUN)ないしsapply(X, FUN)- ふつうXはリスト。各要素に

FUNを適用する。例)x <- strsplit(c("Hello world", "How do you do")," ")。length(x)は 2 を返す。sapply(x, length)は c(2,4)を返す - lapplyは常にリストを、sapplyは(もし可能なら)ベクトルないし行列を返す

- Xがデータフレームの場合、各列にFUNを適用する

- ふつうXはリスト。各要素に

apply(X, MARGIN, FUN)- 配列

Xの次元MARGINにFUNを適用する - 結果はベクトルないし行列

- よく使う

FUNについてはすでに関数が用意してあるので探すこと。rowSums(), colSums(), rowMeans(), colMeans(), etc. - sweep(X, MARGIN, STAT, FUN)のSTATに渡す。例) 列ごとに最大値を出し, 値をその列の最大値で割る:

Y <- sweep(X, 2, apply(X, 2, max) , "/")

- 配列

aggregate(X, BY, FUN)- ふつう

Xはデータフレーム。Xの全列 についてBYごとにFUNを適用 BYはグループ分け変数のリストでなければならない。X$byvar1なんていうのはだめ。X[c("byvar1","byvar2")]ないしlist(v1 = X$byvar1, v2=X$byvar2)とする。BYの値の組み合わせ数ぶんの行を持つデータフレームを返す。BYにNAを持っている行は無視される!

- ふつう

tapply(X, INDEX, FUN)- ベクトル

Xについて、INDEXの値ごとにFUNを適用 FUNがスカラーを返したら、名前付きベクトルないし行列を返す。as.data.frame(as.table(), responseName="xxx")に渡すとよい。responseNameを指定しないと、結果がFreqという列になってしまうFUNがベクトルを返したら、名前付きリストを返す- 例1) INDEXがひとつ

ranges <- tapply(PlantGrowth$weight, PlantGrowth$group, range)

# 下の行でcbindとするとresultは行列になり全要素が文字列に強制変換される

result <- data.frame(

group = dimnames(ranges)[[1]],

matrix (unlist(ranges), ncol=2, byrow=TRUE) #ベクトルの長さが2だとわかってる

) - 例2) INDEXが複数

ranges = tapply(CO2$uptake, CO2[c("Type","Treatment")], range)

# rangesは2x2のmatrixで、その要素が名前なしのリストで、

# リストの要素が長さ2のベクトル。悪夢だ

result <- data.frame(

expand.grid(dimnames(ranges)),

matrix(unlist(ranges),byrow=TRUE,ncol=2)

) - FUNを指定しないと、指定したときに生成されるであろうベクトル(行列, リスト)の添え字を返す

# 中央値を格納する2x2行列。

meds <- tapply(CO2$uptake, CO2[c("Type","Treatment")], median)

# 行数ぶんのベクトル。tapplyが生成する行列の添え字を格納している。

# ここでは(1,1,1,...,3,3,3,....,2,2,2,...,1,1,1...) となる。

inds <- tapply(CO2$uptake, CO2[c("Type","Treatment")])

# それぞれの値から、そのセルの中央値を引くのは

adj.uptake <- CO2$uptake - meds[inds]

# この例は、ave()にFUNを指定しても同じことができる

adj.uptake <- CO2$uptake - ave(CO2$uptake, CO2$Type, CO2$Treatment, FUN=median

- 例1) INDEXがひとつ

- ベクトル

split(X, F)- データフレーム

Xを、因子(のリスト)Fで分割し リストにして返す - 例) iris データセットの"Species" ごとに、残りの変数の相関行列の第一固有値を求める

# もし全体についてだったら

# eigen(cor(iris[setdiff(colnames(iris),"Species")]))$values[1]

frames <- split(iris[setdiff(colnames(iris),"Species")], iris$Species)

maxeig <- function(df) eigen(cor(df))$value1[1]

sapply(frames, maxeig) split()のかわりに行番号をtapply()に与える手もある。 例) iris データセットの"Species" ごとに、残りの変数の相関行列の第一固有値を求める# 話を簡単にするために、"Species"は5列目だとわかっているとしよう

# もし全体についてだったら eigen(cor(iris[-5]))$values[1]

# いま仮に行番号のベクトルがindであるとすると eigen(cor(iris[ind,-5]))$values[1]

maxeig <- function(ind, data) eigen(cor(data[ind,-5]))$values[1]

tapply(1:nrow(iris), iris[5], maxeig, data=iris)

- データフレーム

by(X, INDEX, FUN)- データフレーム

Xについて、INDEXの値ごとにFUNを適用 - 名前付きリストを返す

FUNがデータフレームを返すようにすると便利- 例)

CO2$uptakeの観測数、平均値、標準偏差からなるデータフレームをつくるsumfun <- function(x) {

data.frame(n=length(x$uptake), mean=mean(x$uptake), sd=sd(x$uptake))

}

bb <- by(CO2, CO2[c("Type", "Treatment")], sumfun)

cbind(

expand.grid(dimnames(bb)), # リストbbのグループ因子をデータフレームに展開

do.call (rbind, bb) # rbindにリストbbを与え、要素ごとに処理させている。つまり縦結合

)

- データフレーム

2019年7月12日 (金)

先月終わったセミナーの準備の際に悩んだあれこれを、いまだ気分的に引きずっているのだが...これもそのときにとったメモ。

うーん、やっぱり基礎教養が足りないのだと思う。辛いなあ。でも、もともと文系だし... 別に意図して選んだ仕事じゃないし... (泣き言)

$L$をラグ演算子とする。一階差分方程式

$(1-\phi L) y_t = w_t$

があるとき、$(1-\phi L)^{-1}$をどう定義すればよいか。

ラグ演算子を含む方程式の操作では、$|\phi| < 1$のとき

$(1-\phi L)^{-1} = 1+\phi L + \phi^2 L^2 \cdots$

だと定義するのが普通である。この話はあっちこっちの参考書に書いてある。

しかしここでは$|\phi| \geq 1$である場合について考えたい。この話、なかなか本に書いてないような気がするのです。

そういう例として...

時点$t$におけるある株の価格を$P_t$, 配当を$D_t$とする。ある投資家がこの株を$t$において買い$t+1$において売ったら、この投資家は配当から利率$D_t/P_t$を、売買差益から利率$(P_{t+1}-P_t)/P_t$を得る。リターンは

$r_{t+1} = (P_{t+1}-P_t)/P_t + D_t/P_t$

となる。

話をすごく単純にして、リターン$r_{t+1}$がどの時点でも一定の正の値$r$であるとしよう。

$r = (P_{t+1}-P_t)/P_t + D_t/P_t, \ \ r > 0$ ... [リターン公式]

両辺に$P_t$を掛けて移項すると一階の差分方程式になる。

$P_{t+1} = (1+r)P_t - D_t$ ... [株価の差分方程式]

ところで、一階の差分方程式

$y_t = \phi y_{t-1} + w_t$

は、元の式の右辺に$y_{t-1}, y_{t-2}, \ldots$を逐次代入して

$y_t = \phi^{t+1} y_{-1} + \phi^t w_0 + \phi^{t-1} w_1 + \cdots + \phi w_{t-1} + w_t$

と書き換えられる。従って、株価の差分方程式は

$P_{t+1} = (1+r)^{t+1} P_0 - (1+r)^t D_0 - (1-r)^{t-1} D_1 - \cdots - D_t$

と書き換えられる。

配当$\{D_0, D_1, \ldots, D_t\}$と、初期株価$P_0$の両方が決まれば、株価$\{P_1, P_2, \ldots, P_{t+1}\}$も決まる。初期株価$P_0$が未知の場合には、株価は決まらない。

ちょっと話がそれるんだけど、話をさらにものすごく単純にして、リターン$r_t$は常に$r$、配当$D_t$は常に$D$であるとしよう。

$P_{t+1} = (1+r)^{t+1} P_0 - [(1+r)^t + (1-r)^{t-1} + \cdots + 1] D_t$

カメカッコの中身をよくみると等比数列の和になっている。等比数列の総和ってのは、えーと、$c \neq 1$のときに$\sum_{k=1}^n c^{k-1} = (1-c^n)/(1-c)$でしたね(Wikipediaをみながら書きました)。よって

$P_{t+1} = (1+r)^{t+1} P_0 - \frac{1-(1+r)^{t+1}}{1-(1+r)} D$

分母が$r$になるので、結局こうなる。

$P_{t+1} = (1+r)^{t+1} [P_0 - (D/r)] + (D/r)$

ここでも、初期株価$P_0$が決まらないと株価は決まらない。

- 初期株価が$P_0 = D/r$だったらどうなるか。第1項が消えるので、株価は常に$P_t = D/r$となる。売買差益はゼロになり、全収益は株価に対する配当の比$r = D/P$となる。

- 初期株価が$P_0 > D/r$だったらどうなるか。投資家たちがその株に、配当を超えた価値を見出している場合である。このとき、株価$P_{t+1}$は上がり続ける。バブルみたいな感じですね。

本題に戻して...

話をもうちょっと現実的にする。配当$D_t$は変化する、しかし有界である、としよう。

話をリターン公式

$r = (P_{t+1}-P_t)/P_t + D_t/P_t, \ \ r > 0$

に巻き戻す。両辺に$P_t$を掛けて移項すると

$P_t = \frac{1}{1+r} [P_{t+1} + D_t]$

以下、$R = \frac{1}{1+r}$と略記する。

これに

$P_{t+1} = R [P_{t+2} + D_{t+1}]$

を代入して、さらに$P_{t+2}$を代入して...という風に、時点$T$まで前向きに逐次代入していくと、

$P_t = R^T P_{t+T} + R^T D_{t+T-1} + R^{T-1} D_{t+T-2} + \cdots + R D_t$ ... [★]

となる。

株価$P_t$が有界であれば、第一項の極限は

$\lim_{T \rightarrow \infty} R^T P_{t+T} = 0$

だし、配当$D_t$が有界であれば、第二項以降の和には極限

$\lim_{T \rightarrow \infty} \sum_{j=0}^{T} R^{j+1} D_{t+j}$

が存在する。というわけで、株価と配当が有界であれば、株価は第二項以降の和

$P_t = \sum_{j=0}^{\infty} R^{j+1} D_{t+j}$ ...[ファンダメンタル解]

となる。

ここでは、初期株価$P_0$も上の式で決まるという点にご注目。$D_t=D$としても決まらなかった$P_0$だが、$D_t$が有界だと仮定すれば決まるようになるわけだ。

ずいぶん前置きが長かったが... ここからはラグ演算子$L$をつかってやりなおす。

リターン公式

$r = (P_{t+1}-P_t)/P_t + D_t/P_t \ \ r > 0$

の両辺に$P_t$を掛けて移項して、一階の差分方程式をつくり

$P_{t+1} = (1+r)P_t - D_t$

これをラグ演算子を使って書き換える。

$[1-(1+r) L] P_{t+1} = - D_t$

以下、$\phi = 1+r$と略記する。

さあ、$P_{t+1}$はどうなるか。ここで$\phi > 1$だという点がこの話のミソである。

まず、ラグ演算子そのものの逆数を定義しておく。

$L^{-1} w_t = w_{t+1}$

まず、両辺に$-\phi^{-1} L^{-1}$をかける。左辺は

$[-\phi^{-1} L^{-1}] [1-\phi L] P_{t+1} = [1 - \phi^{-1} L^{-1}] P_{t+1}$

右辺は

$\phi^{-1} D_{t+1}$

となりますね。

さらに、両辺に$1+\phi^{-1} L^{-1} + \phi^{-2} L^{-2} + \cdots +\phi^{-(T-1)} L^{-(T-1)}$を掛ける。左辺はうまいこと整理されて

$P_{t+1} - \phi^{-T} P_{t+T+1}$

となる。右辺は

$\phi^{-1} D_{t+1} + \phi^{-2} D_{t+2} + \cdots +\phi^{-T} D_{t+T}$

となる。つないで移項すると

$P_{t+1} = \phi^{-T} P_{t+T+1} + \phi^{-1} D_{t+1} + \phi^{-2} D_{t+2} + \cdots +\phi^{-T} D_{t+T}$

よくよくみると、★式を1期ずらした式になっていますね。

$r >0$で、株価$P_t$が有界であれば、$T$が十分に大きい時、左辺から移行した第1項$\phi^{-T} P_{t+T+1}$は無視できる。従って、$r >0$で$P_t$と$D_t$が有界であれば、両辺に$-\phi^{-1} L^{-1} [1+\phi^{-1} L^{-1} + \phi^{-2} L^{-2} + \cdots +\phi^{-(T-1)} L^{-(T-1)}]$を掛けるという演算子は、その極限において、演算子$(1-\phi L)$の逆数だとみることができる。

というわけで、$(1-\phi L)$の逆数は、$|\phi| < 1$のとき

$(1-\phi L)^{-1} = 1 + \phi L + \phi^2 L^2 + \phi^3 L^3 + \cdots$

$|\phi| > 1$のとき

$(1-\phi L) ^{-1} = -\phi^{-1} L^{-1} \left[ 1 + \phi^{-1} L^{-1} + \phi^{-2} L^{-2} + \cdots \right]$

と定義できる。

ただし、いずれの場合も、$y_t$, $w_t$が有界であるという暗黙の仮定があることに注意すべし。

... 以上、Hamilton(1994) の2.5節からメモ。

ううう、わからん...

この本の2.2節には、$|\phi| < 1$のときの$(1- \phi L)$の性質についての説明があり、末尾に「$|\phi| \geq 1$のときの$[1-\phi L] ^{-1}$の性質については2.5節をみよ」と書いてある。ハミルトン先生、$|\phi| > 1$についてはわかりました。では、$|\phi| = 1$のときの$[1-\phi L] ^{-1}$はどう定義すればよろしいのでしょうか。

愚かな私の考えるところによれば、差分方程式

$y_{t} = y_{t-1} + w_t$

$(1-L) y_t = w_t$

において、$w_t$が有界でも$y_t$は有界じゃないし、仮に$y_t$が有界だと仮定したところで、$w_t$が与えられても$y_t$はなお未知だから、$(1-L)^{-1}$は定義できないように思うのですが、正しいでしょうか?

それとも、$(1-L)^{-1}$とは

$(1-L)^{-1} w_t = y_t = y_0 + \sum_{t=1}^{t} w_t$

となる演算子、つまり「演算子の左に書いてある奴をt=1から累積して初期値を足せ」という奇妙な演算子だと考えるべきなのでありましょうか???まさかねえ...

2019年1月20日 (日)

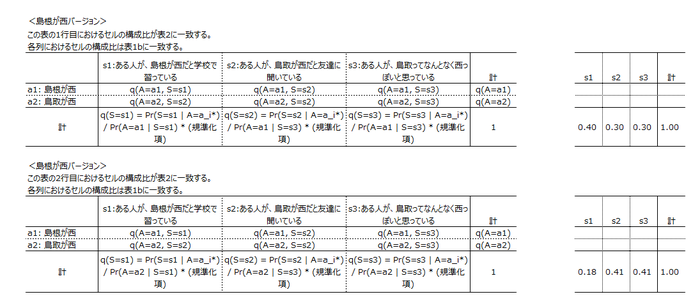

構造方程式モデリング界の帝王、泣く子も黙るMplus様には分厚いマニュアルがついていて、膨大な数のモデル例が紹介されている。そのなかには私には到底理解できないものもあれば、いっけん易しそうだがよく考えてみるとわけがわからないものもある。

後者のひとつがExample 9.26「Cross-classifiedデータのランダム二値項目IRTモデル」で、よんどころない都合により、本日はずっとこの事例についてあれこれ思い悩んでいた。そりゃあ出世しないわ...!

というわけで、この事例について考えたことをメモしておく。文字通り、私の・私による・私のためのメモであって、いちいちブログに書くんじゃないよ、情けないな、という気もする。

Example 9.26とはこういうモデルである。Mplus 7.2から追加された TYPE=CROSSCLASSIFIEDを使っている。

VARIABLE: NAMES = u subject item;

CATEGORICAL = u;

CLUSTER = item subject;

ANALYSIS: TYPE = CROSSCLASSIFIED RANDOM;

ESTIMATOR = BAYES;

PROCESSORS = 2;

MODEL: %WITHIN%

%BETWEEN subject%

s | f BY u;

f@1;

u@0;

%BETWEEN item%

u; [u$1];

s; [s];Mplusのサイトで公開されているデータを確認したところ、クラスタ変数 item は50水準, subjectは100水準。で、subject * item ごとに1行を持つ5000行のデータである。

このモデルを数式で表現してみよう。

コードに登場する変数は、u, item, subjectの3つ。そのうちitem と subject はCLUSTER=に指定されている。以下、subject を$i$, item を$j$とする。データの構造をコードから知るのは難しいが、上で確認したように、u は subject * item ごとにひとつ得られている二値の測定値である。これを$u_{ij}$と書く。

VARIABLEセクションの注目点は2つ。

- CLUSTER= item subject; となっている。あれこれ試していて気が付いたのだが、後述するように、CLUSTER=で指定する順番は無意味ではない。Mplusのマニュアルでは、cross-classifiedモデルにおける2つのbetweenレベルは2A, 2Bと表現されていて、CLUSTER=で最初に指定したのが2B, 次が2Aになる。ここではsubjectが2A, itemが2Bである。

- WITHIN=もBETWEEN=もない。ここで、u の指定は次の4通りがあり得た。(1)WITHIN=に指定する、(2)BETWEEN=で subject レベルの変数として指定する、(3)BETWEEN=で item レベルの変数として指定する、(4)WITHIN=でもBETWEEN=でも指定しない。ここでは(4)が選択されているわけで、$u_{ij}$が、subjectのレベルでもitemのレベルでもモデル化される、ということがわかる。

なお、$u_{ij}$がWITHINレベルでモデル化されるかどうかは、これだけではわからない(このことに気が付くまでに時間がかかった)。通常の階層モデル(TYPE = TWOLEVEL)では、ある変数がWITHIN=にもBETWEEN=にも指定されていないとき、その変数はどちらのレベルでもモデル化されるということがわかる。しかし、TYPE=CROSSCLASSIFIEDの場合は一概にそうともいえないのだ。このExample 9.26がよい例で、実は$u_{ij}$はWITHINレベルではモデル化されていない($u_{ij}$のモデルを式で表現したとき、その右辺に、$ij$を添え字に持つ項がない)。

MODELセクションに移ろう。

Mplusでは、カテゴリカル従属変数の背後には連続潜在変数が想定される。これを$u^*_{ij}$と書く。デフォルトではプロビット・リンクになる。つまり、標準正規分布関数を$\Phi$として

$Prob(u_{ij}=1 | u^*_{ij}) = \Phi(u^*_{ij} - \tau)$

である。%BETWEEN item%に [u$1] と指定されているから、ついつい$\tau$が item ごとに動くのかと考えてしまったのだが、そうではない。(ここも私が混乱した点のひとつであった。考えてみれば、通常のTWOLEVELモデルで%BETWEEN%に [u$1]と指定したら、それは動かないよね。落ち着け俺)

なお、Mplusのアウトプット上では、[u$1]は item レベルのパラメータとして扱われる。%BETWEEN item%に[u$1]と書こうが書くまいが結果は変わらない。%BETWEEN subject%に[u$1]と書くとエラーになり、ふたつあるBETWEENのどっちかで固定しろといわれる。そこで

MODEL: %WITHIN%

%BETWEEN subject%

s | f BY u;

f@1;

u@0; [u$1];

%BETWEEN item%

u; [u$1@0];

s; [s];u$1は0に固定され、結果として自由パラメータがひとつ減る。想像するに、MODEL=CROSSCLASSIFIEDにおいてカテゴリカル従属変数の閾値を推定する際は、レベル2B(つまり、CLUSTER=で1つめに指定したクラスタ変数のレベル)でしか指定できない、というルールがあるのかもしれない。

ここからは$u^*_{ij}$のモデル。

まずは、説明変数は無視して残差項にだけ注目しよう。uは%WITHIN%には登場せず、%BETWEEN subject%では u@0, %BETWEEN item%では u となっている。つまり、残差はsubject間では動かず、item間で動く。itemを「テスト項目」と捉えるなら、残差という言い方はなんだか変だな。むしろ切片というべきであろう。これを$a_j$と書き、その分散を$\sigma_a^2$と書こう。

いよいよ説明変数について考える。はい深呼吸!

%BETWEEN subject%に s | f BY u と指定されている。つまり、われらが $u^*_{ij}$は謎の潜在変数 f の指標なのだ。この潜在変数を $F$と書こう。[f]という記載がどこにもないので平均は0, f@1とあるので分散は1である。

sは因子負荷である。おさらいしよう。Mplusでは、縦棒を使って傾きや因子負荷に名前を付けると、それはただの傾き・因子負荷ではなく、BETWEENレベルで変動するランダム傾き・ランダム因子負荷になる。通常の階層モデル(TYPE=TWOLEVEL RANDOM)では、%WITHIN%において s | y ON x; とかs | f BY y; と指定するのが常道である。このとき、WITHINレベルでは(つまりクラスタの中では) s は変動しない。ただし、ランダム傾きに限り、アスタリスクをつけて s* | y ON x; と書けば、sはクラスタ内でも変動する。

しかし TYPE = CROSSCLASSIFIED RANDOMでは勝手が違う。まず、ランダム傾きだろうがランダム因子負荷だろうがアスタリスクは使えない。つまり、そのレベルでは変動しない。さらに、%WITHIN%だけでなく%BETWEEN%でも指定できてしまう。%BETWEEN%で指定した場合、そのレベルでは変動しないけど、隣のレベルでは変動しうるのだ。びっくり!

ここでは、sは%BETWEEN subject%で定義され、%BETWEEN item%で s; [s]; とある。ってことは、このモデルでは、因子負荷 s は subject によっては動かないが、itemによって動くのだ。sを $s_j$と書き、その平均を$\mu_s$, 分散を$\sigma_s^2$と書こう。

というわけで、この事例を数式で書き下ろすと、こういうモデルだと思う。

$Prob(u_{ij}=1 | u^*_{ij}) = \Phi(u^*_{ij} - \tau)$

$u^*_{ij} = a_j + s_j F_i $

$E(F) = 0, \ \ Var(F) = 1$

$a_j \sim N(0, \sigma_a^2), s_j \sim N(\mu_s, \sigma_s^2)$

推定するパラメータは、$\tau, \mu_s, \sigma_s^2, \sigma_a^2$の4つである。

つまりこのモデルは、50指標1因子のカテゴリカル因子分析モデル、ないしIRTモデルといってよいと思う。ちがいは、因子負荷$s_1, \ldots, s_{50}$, 項目切片$a_1, \ldots, a_{50}$をモデルのパラメータとみるのではなく、確率変数の実現値として捉えているという点である。

覚え書き: Cross-classifiedデータのランダム二値項目IRTモデルをMplusで表現する

2019年1月18日 (金)

cross-classifiedマルチレベルモデルについて大急ぎで勉強する必要が生じ、よく引用されている参考書である

Raudenbush, S.W., Bryk, A. (2002) Hierarchical Linear Models: Applications and Data Analysis Methods. Second Edition.

を急遽注文し、12章だけ読んだ。さぞや難しかろうと覚悟していたのだが、意外にもわかりやすい内容であった。

若くてやる気のある学生のみなさんに私がひとつだけ勝てるとしたら、このように、高めの本をためらいなくバカスカ買っちゃうということだけなのである... 悲しい...

以下はそのメモ。

本章ではデータが階層的ではあるんだけどきれいな階層になっていなくて、複数のユニットにcross-classifyされているようなデータについて扱う。子供が地域と学校に属しているとか、子供が中学と高校に属しているとか、従業員を職業と産業で分類するとか。

なお、子供がある学校に属していて、学校の中で実験群か統制群のどちらかに割り当てられている、というような場合と、構造は似ているけど全然違う。「子どもが地域と学校に属している」場合、分析者は結果をいろんな地域・学校に一般化したいと思っているので、地域と学校はランダム効果である。「子どもが学校と実験条件に属している」場合、いろんな地域に一般化したいとは思うが「実験条件の母集団」というのはないので、学校はランダム効果で実験条件は固定効果となり、実験条件をlevel-1変数にとったtwo-levelとなる。

以下、子ども$i$, 地域$j$, 学校$k$に属する子ども$i$の到達度を$Y_{ijk}$とする。

まずunconditonalなモデル(予測子のないモデル)について。

withinモデルは

$Y_{ijk} = \pi_{0jk} + e_{ijk}$

$e_{ijk} \sim N(0, \sigma^2)$

betweenモデルは

$\pi_{0jk} = \theta_0 + b_{00j} + c_{00k} + d_{0jk}$

$b_{00j} \sim N(0, \tau_{b00})$

$c_{00k} \sim N(0, \tau_{c00})$

$d_{00j} \sim N(0, \tau_{d00})$

$b_{00j}$は地域$j$の効果, $c_{00k}$は学校$k$の効果, $d_{0jk}$は学校と地域の交互作用効果。セル(学校x地域)のサイズが小さい時は交互作用効果の推定は無理。

このモデルはこう書き換えられる。

$Y_{ijk} = \theta_0 + b_{00j} + c_{00k} + d_{0jk} + e_{ijk}$

要するに二元配置分散分析である。

分散が$\sigma^2, \tau_{b00}, \tau_{c00}, \tau_{d00}$に分解されたので、ユニット内相関係数も3種類定義できることになる[...メモ省略]

ではconditionalなモデルについて。

地域特性を$W_j$, 学校特性を$X_k$とする。話を単純にするため、どちらも1変数、固定効果、2水準(実験群と 統制群)とする。個人特性を$a_{ijk}$とする。話を単純にするため、1変数2水準(男と女)とする。

withinモデルは

$Y_{ijk} = \pi_{0jk} + \pi_{1jk} a_{ijk} + e_{ijk}$

$e_{ijk} \sim N(0, \sigma^2)$

さて、betweenモデルは...

まずは簡単に、地域の予測子の効果も学校の予測子の効果も固定と考えよう。以下、$\pi_{0jk}$と$\pi_{1jk}$を一発で書くために、$p=0,1$とする。

$\pi_{pij} = \theta_p + b_{p0j} + \gamma_p W_j + c_{p0k} + \beta_p X_k + d_{pjk}$

このモデルだと、地域の効果は全学校で共通、学校の効果は全地域で共通である。

これを緩和すると

$\pi_{pij} = \theta_p + b_{p0j} + (\gamma_p + c_{p1k}) W_j + c_{p0k} + (\beta_p + b_{p1j}) X_k + d_{pjk}$

地域特性と学校特性の交互作用をいれると

$\pi_{pij} = \theta_p + b_{p0j} + (\gamma_p + c_{p1k}) W_j + c_{p0k} + (\beta_p + b_{p1j}) X_k + \delta_p X_k W_j + d_{pjk}$

実際には、理論と照らし合わせて、もうちょっと簡略にしないといけないわけで...

ここからは実例の紹介。

実例1, 子どもの達成に地域と学校がどう効くか研究。

withinモデルは

$Y_{ijk} = \pi_{0jk} + \pi_{1jk} a_{ijk} + e_{ijk}$

$e_{ijk} \sim N(0, \sigma^2)$

betweenでは主効果だけ考えた。

$\pi_{0jk} = \theta_0 + b_{00j} + c_{00k}$

$b_{00j} \sim N(0, \tau_{b00})$

$c_{00k} \sim N(0, \tau_{c00})$

このモデルを推定して級内相関を求めると...[略]

予測子をいれてみます。withinレベルで、入学前の言語能力VRQと読み到達度Reading, 父親の職業DADOCCと教育DADED, 母親の教育MOMEDと働いているかDADUNEMP, 性別SEX。地域特性は、社会的剥奪レベルDEPRIVATION。ただし、学校によって違ってくるかもしれないので

$\pi_{0jk} = \theta_0 + (\gamma_{01} + c_{01k})DEPRIVATION_j + b_{00j} + c_{00k} $

とし、$(c_{00k}, c_{01k})'$の分散共分散を3つすべて推定した。で、カイ二乗検定で「$c_{01k}$の分散も$c_{00k}$との共分散も0」という帰無仮説が棄却されなかったので、$c_{01k}$を取っ払った。[←なるほど...]

実例2はめんどくさいので読み飛ばした。

勉強になりましたです...

実例1で、地域特性の効果が学校によって違うってのをモデル化しているけど($(\gamma_{01} + c_{01k})W_j$という項をいれる。なるほどねえ)、こういうのMplusだとどうやって指定するんだろう?

そうか、私がいまやりたいのは

$Y_{ijk} = \theta_0 + b_{00j} + b_{01j} c_{00k} + e_{ijk}$

というモデルだということに気が付いた。うーむ、こういうのはMplusだとどうなるんだ???

覚え書き:cross-classifiedなマルチレベルモデル

2019年1月 6日 (日)

昨年暮れ、学会発表のための分析をやっててわけがわからなくなり、頭を整理するために、Mplusユーザーズ・マニュアル9章(complex survey dataの階層モデリング)の事例40個を全部読んだ。そのときにとったメモ。

事例9.30-9.40はAR(1)構造がはいって難しさもさらにグレードアップするのだが、当面使う予定がないので(←言い訳)、メモも省略している。

- TYPE=TWOLEVELで、WITHINレベルでもBETWEENレベルでも x が y に刺さっているとき、データとしてxのクラスタ別平均 xm をつくっておいて、 MODELで

とする手と、単に%WITHIN%

y ON X;

%BETWEEN%

y ON xm;

とする手がある。前者の場合はDATAでWITHIN=x; BETWEEN=xm;と宣言すること。いっぽう後者の場合、xはWITHINレベルの潜在変数とBETWEENレベルの潜在変数に分解されていることになる。階層回帰モデルの一般的アプローチではないけれど、xmの信頼性が低いときに後者がお勧め。[←これを読んで、むしろ前者がアリだということに驚いた。個票があるのに標本平均をデータにするなんて邪道という気がするが、クラスタのサイズが十分に大きければ構わんってことか...] なお、後者のモデルにおけるBETWEENレベルの係数とWITHINレベルの係数の差を、Raudenbush & Bryk (2002)は「文脈効果」と呼んでいる[←どういう意味だろう?](事例9.1)%WITHIN%

y ON x;

%BETWEEN%

y on x; - TYPE=RANDOMのときの縦棒("|")の左はランダム回帰係数の名前を表すが、TYPE=TWOLEVEL RANDOMで%WITHIN%での指定だったらそのランダム回帰係数はBETWEENレベルの変数になりますわね。ところがアスタリスクをつけると(「s* | y on x」という風に)、これはWITHINでも分散を持つようになる。[←これはほんとに、いままでぜんっぜん知らなかった。こういうことがあるからMplusは怖い...] (事例9.14)

- TWOLEVEL RANDOMでは、

というようなモデルを組める。logvはyの残差分散の対数を表す。[そうそう、これも謎の機能で... ESTIMATOR=BAYESが登場してから追加された機能だと思う。理屈はわかるけど、どういうときに使えばいいのかがいまいちわからない。係数がクラスタによって違うモデルをつくりたいというのはわかるけど、残差分散がクラスタによって違うモデルをつくりたいってことはあるのか...あるか... そうか...] (事例9.28)%WITHIN%

logv | y;

%BETWEEN%

logv on w;

ところで、Mplusは結構長く使っているはずなのだが、それでも「えええ、そんなことができるの」と呆れたモデルがあったので、呆れついでにメモしておく。事例9.26。変数はu(カテゴリカル)、subject, itemの3つ、subjectとitemがクラスタのCROSSCLASSIFIED RANDOMモデル(THREELEVEL RANDOMではないという点に注意)。

%WITHIN%

%BETWEEN subject%

s | f BY u; f@1; u@0;

%BETWEEN item%

u; [u$1]; s; [s]; つまり、subjectレベルではuは分散1の潜在変数fに残差無しで規定されていて、その負荷というかプロビット回帰係数がsである(uをテスト項目の正誤とすると、fは対象者の能力、sは項目の識別性のようなものであろう)。uはitemレベルで切片が動き、残差分散も動く。さらにsも、subjectのなかでは動かないけどitemレベルで動く。ええええ... そういうのを組みたくなる動機はわかるけど、まさかほんとに組めるとは。 sはsubjectレベルで定義されているからitemレベルではモデル化できないかと思った。CROSSCLASSIFIEDモデルおそるべし。

いやあ、やっぱり使っているソフトのマニュアルは読むべきだ... 読むべきものが多すぎて辛い...

Mplusについては、Muthen一家の手によるものを含め、多種多様なレベルの解説が手に入るのだが、CROSSCLASSIFIEDモデルについてのまとまった解説は見当たらない。どこかにないかしらん。

2019/01/20追記: 事例9.26のコードについて誤解していたことにあとで気が付いた。CROSSCLASSIFIEDおそるべし。

覚え書き: Mplusがご提供する階層モデリングのための謎機能たち

2018年10月30日 (火)

仕事の都合で、統計学の一般的な知識についてのご相談を頂くことがある。そうしたご相談の、そうだなあ...4割か5割くらいは、南風原「心理統計学の基礎」を熟読すれば答えられる内容である。いうなれば、私の日々の仕事の一部は、南風原本を適宜わかりやすく言い換えることに過ぎない。嗚呼、哀れな人生。

しかし、ここにふたつの問題がある。(1)ご相談を受けてから熟読している時間はない。(2)前もって熟読していたとしても、覚えていられるとは限らない。

幸か不幸か、私は人生においてヒマな時期が結構長かったので、(1)の問題は一応クリアしているんだけど(つまり、2002年の刊行時にかなり真剣に読んだんだけど)、(2)の問題が壁となって立ちはだかる。特に最近は、この壁がすごく、すごーく、ものすごーく高い。

このたび都合であれこれ説明を書いていて、ああこの話って、あの本の8章、部分相関係数とか偏相関係数とかからはじめてTypeIII平方和に至るくだりの、下手な書き換えに過ぎないなあ... と気が付いた。

というわけで、せめてもの忘備録として、8章の内容をメモしておきます。

事例を剥ぎ取って要点のみメモする。なので、メモだけをみると、いっけんすごく難しい話のようにみえるだろうと思う。

南風原先生の略記法とはちがい、変数$X$の標準偏差を$s[X]$, $X,Y$の相関係数を$r[X,Y]$と略記する。

8.1 部分相関係数と偏相関係数

ここに変数$y, x_1, x_2$がある。$x_2$と$y$の間には、その両変数と$x_1$との相関関係だけでは説明できないような独自の関係があるか。

$x_2$を、$x_1$によって完全に予測可能な成分と、$x_1$と完全に無相関な成分$x_2|x_1$とにわけ、$x_2|x_1$と$y$との相関

$\displaystyle r[y, (x_2|x_1)] = \frac{r[y, x_2] - r[y, x_1] r[x_1,x_2] }{ \sqrt{1-r^2[x_1, x_2]} }$ [8.1]

を調べよう。これを部分相関係数part correlation coefficient, ないし片偏相関係数(半偏相関係数) semipartial correlation coefficentという。

部分相関係数においては、$x_2$からは$x_1$の影響を除いてあるが、$y$に関してはもとのままである。そこで、$y$から$x_1$の影響を除いた$y|x_1$と、$x_2|x_1$との相関

$\displaystyle r [(y|x_1), (x_2|x_1)] = \frac{r[y, x_2] - r[y, x_1] r[x_1,x_2]}{\sqrt{1-r^2[y, x_1]} \sqrt{1-r^2[x_1, x_2]}}$ [8.2]

も調べよう。これを偏相関係数partial correlation coefficientという。

$x_1$から$x_2$と$y$にパスが刺さるパス図で考えると、部分相関係数$r[y, (x_2|x_1)]$は「$y$と、$x_2$の残差との相関」であり、偏相関係数$r [(y|x_1), (x_2|x_1)]$とは「$y$の残差と、$x_2$の残差との相関」である。

部分相関係数と偏相関係数の間には次の関係がある。

$\displaystyle r [(y|x_1), (x_2|x_1)] = \frac{ r [(y|x_1), (x_2|x_1)] }{ \sqrt{1-r^2[y, x_1]} }$ [8.3]

8.2 偏回帰係数とその解釈

ここで唐突におさらいしますが、一般に、散布図の横軸が$X$、縦軸が$Y$のとき、回帰係数は

$b[X,Y] = r[X,Y] \times (s[Y] / s[X])$ [3.13]

$X$で$Y$を予測したときの予測の標準誤差は

$s[e] = s[Y] \sqrt{1-r^2[X,Y]}$ [3.25]

である。

本題に戻って...

横軸に$x_2|x_1$、縦軸に$y$をとった散布図に、回帰直線をあてはめてみよう。

- 相関にあたるのは、部分相関係数$r[y, (x_2|x_1)]$

- 横軸の標準偏差は、$x1$で$x2$を予測したときの予測の標準誤差だから、[3.25]より $s[x_2|x_1] = s[x_2] \sqrt{1-r^2[x_1, x_2]}$ [8.4]

- 縦軸の標準偏差は、$y$の標準偏差$s[y]$

以上により、この散布図にあてはめた回帰直線の傾き

$b[ y, (x_2|x_1) ]$

は、[3.13]より

$\displaystyle = r[ y, (x_2|x_1)] \frac{s[y]}{s[x_2|x_1]}$

[8.1],[8.4] を代入して

$\displaystyle = \frac{r[y, x_2] - r[y, x_1] r[x_1,x_2]}{\sqrt{1-r^2[x_1, x_2]}} \times \frac{ s[y] }{ s[x_2] \sqrt{1-r^2[x_1, x_2]} }$

$\displaystyle = \frac{r[y, x_2] - r[y, x_1] r[x_1,x_2]}{ 1-r^2[x_1, x_2] } \times \frac{ s[y] }{ s[x_2] }$ [8.5]

これを偏回帰係数 partial regression coefficientと呼ぶ。なお、横軸に$x_2|x_1$、縦軸に$y|x_1$をとっても、同じ偏回帰係数が得られる。

[8.5]の第2項は標準偏差の比である。仮に$x_2$と$y$をまず標準偏差1に標準化してから求めたなら、この項は消えて、

$\displaystyle b^{*}[ y, (x_2|x_1) ] = \frac{r[y, x_2] - r[y, x_1] r[x_1,x_2]}{ 1-r^2[x_1, x_2] }$ [8.7]

これを標準偏回帰係数standardized partial regression coeffientという。

部分相関係数[8.1], 偏相関係数[8.2], 標準偏回帰係数[8.7]は分母のみ異なるという点に注目すべし。

8.3 重回帰モデル

ここからは、

$y = \alpha + \beta_1 x_1 + \beta_2 x_2 + \epsilon$ [8.10]

という線形モデルを考える。なお、推測に際しては

$\epsilon | x_1, x_2 \sim N(0, \sigma^2_\epsilon)$

という確率モデルを想定する。

ここから、

$E[y | x_1, x_2] = \alpha + \beta_1 x_1 + \beta_2 x_2$

である。これを回帰平面ないし予測平面と呼ぶ。

母数$\alpha, \beta_1, \beta_2$の推定量を$a, b_1, b_2$とすると

$\hat{y} = a + b_1 x_1 + b_2 x_2$

残差 $e = y - \hat{y}$の二乗和 $Q = \sum_i^N e_i^2$を最小化する推定量は

$\displaystyle b_1 = \frac{r[y,x_1] - r[y, x_2] r[x_1,x_2]}{1-r^2[x_1,x_2]} \times \frac{s[y]}{s[x_1]}$ [8.15]

$\displaystyle b_2 = \frac{r[y,x_2] - r[y, x_1] r[x_1,x_2]}{1-r^2[x_1,x_2]} \times \frac{s[y]}{s[x_2]}$ [8.16]

$\displaystyle a = \hat{y} - b_1 \bar{x}_1 - b_2 \bar{x}_2$ [8.17]

なお、[8.16]は[8.5]と同じである。

$y$と$\hat{y}$の相関係数は

$\displaystyle R = \sqrt{ \frac{r^2[y,x_1] + r^2[y,x_2] - 2 r[y,x_1] r[y,x_2] r[x_1,x_2]}{1-r^2[x_1,x_2]} }$ [8.20]

これを重相関係数multiple correlation coefficientという。重相関係数は、独立変数の1次式で与えられる変数と従属変数との相関のうち最大のものである。

8.4 重回帰分析の仕組み

平均0に中心化したデータを$\mathbf{y}, \mathbf{x_1}, \mathbf{x_2}$とする。

予測値ベクトルは

$\hat{\mathbf{y}} = b_1 \mathbf{x_1} + b_2 \mathbf{x_2}$

である。これは$\mathbf{x_1}, \mathbf{x_2}$によって張られた平面上のベクトルである。

その先端から$\mathbf{y}$に向かうベクトルが残差ベクトル$\mathbf{e}$である。最小二乗法では、$\mathbf{e}$の長さを最小にするように$\hat{\mathbf{y}}$を決める。つまり、$\mathbf{y}$から平面に垂線をおろし、その足を$\hat{\mathbf{y}}$の先端に決めているわけである。

重相関係数$R$とは、$\mathbf{y}$と$\hat{\mathbf{y}}$のなす角度のコサインである。これを最大にするように$\hat{\mathbf{y}}$を決めている、といってもよい。

重相関係数$R$はどういうときに大きくなるか。

まず、単独で高い相関を持つ独立変数があれば大きくなる。これは、$\mathbf{y}$が$\mathbf{x_1}$に近づくにつれて平面も近づいていく、と理解できる。

独立変数間の相関が-1に近いときにも大きくなる(「0に近いとき」でない点に注意)。これは、$\mathbf{x_1}, \mathbf{x_2}$と$\mathbf{y}$との角度を保ったまま$\mathbf{x_1}$と$\mathbf{x_2}$の角度を拡げると、平面が$\mathbf{y}$に近づいていく、と理解できる(90度に拡げた瞬間なにか特別なことが起きるわけでない点に注意)。

$\mathbf{x_1}$と$\mathbf{x_2}$の相関が高いとき、$\hat{\mathbf{y}}$が少し変動するだけで$b_1, b_2$が大きく変動する。

このことは、独立変数間に高い相関があると、サンプリングによる偏回帰係数の変動が大きくなることを意味している。これを多重共線性という

偏回帰係数の標準誤差は

$\sigma[b_1] = \sigma[e] / (\sqrt{N} s[x_1] \sqrt{1-r^2[x_1,x_2]})$ [8.23]

$\sigma[b_2] = \sigma[e] / (\sqrt{N} s[x_2] \sqrt{1-r^2[x_1,x_2]})$ [8.24]

一般化すると

$\sigma[b_j] = \sigma[e] / \left( \sqrt{N} s[x_j] \sqrt{1-R^2[x_j, x_1,\cdots (x_j) \cdots x_p]}) \right)$ [8.25]

である($R^2[x_j, x_1,\cdots (x_j) \cdots x_p]$は$x_j$とそれ以外のすべてとの重相関係数)。他の変数との相関が高いほど大きくなるのがわかる。

最後に、偏回帰係数を幾何学的に説明しよう。[←ここがこの本の難関のひとつだと思うんですよね...」

8.2節にいわく、偏回帰係数とは、横軸に$x_2|x_1$、縦軸に$y$をとった散布図の回帰係数である。また8.3節にいわく、偏回帰係数とは、$x_1, x_2$で$y$を予測するときの係数である。

$\mathbf{x_1}, \mathbf{x_2}$で張られた平面を考えよう。$\mathbf{x_2|x_1}$とは、$\mathbf{x_2}$の先端から$\mathbf{x_1}$に下した垂線を逆向きにしたベクトルである。当然、平面に乗っている。話を簡単にするため、こいつをずずずっと平行移動して、始点を原点に揃えよう。$\mathbf{x_2|x_1}$は$\mathbf{x_1}$と原点で直交しているわけね。

こいつで$\mathbf{y}$を予測しよう。上空に斜めに伸びている$\mathbf{y}$の先端から、平面に垂線を降ろすんじゃなくて、$\mathbf{x_2|x_1}$に向けて垂線を降ろす(上空から斜めに落ちてくる線になる)。その足が、ベクトル$b_2(\mathbf{x_2|x_1})$の先端。これが8.2節の説明である。

今度は、$\mathbf{y}$の先端から平面に垂線を降ろそう。その足の位置から、$\mathbf{x_1}$と平行に(つまり$\mathbf{x_2|x_1}$と垂直に)$\mathbf{x_2}$に移動し、ぶつかったところが、偏回帰係数$\times \mathbf{x_2}$の先端である。これが8.3節の説明。図に書いてみると、なるほど、それは$b_2\mathbf{x_2}$となる。

なお、部分相関係数$r[y, (x_2|x_1)]$とは、$\mathbf{y}$(上空に斜めに伸びている)と$\mathbf{x_2|x_1}$(さっき地表に引いた新しい線)がなす角度のコサインである。

$\mathbf{y|x_1}$とは、$\mathbf{y}$の先端から$\mathbf{x_1}$に斜めに降ろした垂線を逆向きにしたベクトルである。これを原点へと平行移動すると、それは、$\mathbf{x_2|x_1}$(さっき地表に引いた新しい線)の原点を押さえて先端を持ち、$\mathbf{x_1}$との角度を変えないようにまっすぐに引き上げ、$\mathbf{y}$の先端の高さまで伸ばした新しい棒となる。偏相関係数$r[(y|x_1), (x_2|x_1)]$とは、この引き上げ角度がなすコサインである。

5. 平方和の分割と重相関係数の検定

$\mathbf{y}, \hat{\mathbf{y}}, \mathbf{e}$は直角三角形をなしているんだから、

$||\mathbf{y}||^2 = ||\hat{\mathbf{y}}||^2 + ||\mathbf{e}||^2 $ [8.26]

ベクトルの長さは平方和だから

$SS[y] = SS[\hat{y}] + SS[e]$ [8.27]

分散説明率は

$SS[\hat{y}] / SS[y] = ||\hat{\mathbf{y}}||^2 / ||\mathbf{y}||^2 = cos^2 \theta[y,\hat{y}] = R^2$ [8.28]

[8.27] より

$R^2 = 1 - SS[e] / SS[y]$ [8.29]

である。

$SS[y]$の自由度は$N-1$。残差平方和$SS[e]$の自由度は平方の数から母数の数を引いたもので、ここで母数は$p+1$だから(切片がはいる)、自由度は$N-p-1$。よって$SS[\hat{y}]$の自由度は$p$である。

予測の誤差分散と標準誤差はそれぞれ

$s^2[e] = SS[e] / N = SS[y] (1-R^2)/N = s^2[y] (1-R^2)$ [8.32]

$s[e] = s[y] \sqrt{(1-R^2)}$ [8.33]

だが、$\sigma[e]$の推定量としては(そして予測の標準誤差としても)、自由度$N-p-1$で割った不偏推定量

$s^{'}[e] = s[y] \sqrt{N/(N-p-1)}$ [8.34]

を使うことが多い。同様に、$\sigma^2[y]$の推定量としても$s^{'2}[y] = SS[y] / (N-1)$を使うことが多い。[8.29]を書き換えると

$R^2_{adj} = 1 - \sqrt{\frac{N-1}{N-p-1}}(1-R^2)$

これが自由度調整済み決定係数である。$R^2$が$p$の増大につれて過大になるのを修正しているわけだ。

重相関係数がゼロであるという帰無仮説の下で、

$F = \frac{SS[\hat{y}]/p}{SS[e]/(N-p-1)}$ [8.36]

は自由度$p, N-p-1$のF分布に従う。[8.28]で書き換えると

$F = \frac{R^2/p}{(1-R^2)/(N-p-1)}$ [8.36]

である。

6. 個々の独立変数の寄与の評価

[8.20]から$r^2[y,x_1]$を引くと

$\displaystyle R^2 - r^2[y, x_1] = \frac{(r[y,x_2]-r[y,x_1]r[x_1,x_2])^2}{1-r^2[x_1,x_2]}$

となる。よくみると、これは[8.1]の部分相関係数$r[y, (x_2|x_1)]$の二乗である。

これは独立変数の数に限らず成り立つ。つまり、$q$個[原文では$p_1$個]の独立変数からなるモデルに変数を1個以上加えて$p$個にした時の決定変数の増分は、部分相関係数の二乗になる。これを

$R^2[y,x_1\cdots x_p] - R^2[y,x_1\cdots x_q] = r^2[y, (x_p|x_1\cdots x_q)]$

と書こう。

追加した$p-q$個の偏回帰係数について、帰無仮説

$H_0: \beta[x_{q+1}] = \cdots = \beta[x_p] = 0$

を検定することができる。検定統計量

$\displaystyle F = \frac{(R^2[y, x_1\cdots x_p]-R^2[y,x_1\cdots x_q])/(p-q)}{(1-R^2[y, x_1\cdots x_p])/(N-p-1)}$ [8.43]

が帰無仮説の下で自由度$p-q, N-p-1$のF分布に従う。

上で述べた独立変数の寄与の評価は、独立変数の投入順で変わってくる。

投入順を決め、各ステップにおける$R^2$の増分に全平方和$SS[y]$を掛けて得られる平方和をタイプIの平方和という。

投入順は決められないことが多い。そこで、それぞれの独立変数を最後に投入したと想定し、部分相関係数の二乗に全平方和$SS[y]$を掛ける。これをタイプIIIの平方和という。

[8.25]で示した偏回帰係数の標準誤差$\sigma[b_j]$の、分子の$\sigma[e]$を$s^{'}[e]$で置き換えて$s[b_j]$とし、これと偏回帰係数$b_j$を比較した $t = b_j / s[b_j]$ は、$H_0: \beta_j = 0$の下で自由度$N-p-1$のt分布に従う。

[8.43]で追加した変数が1個だった場合の$F$は、この$t$の二乗になる。つまり、偏回帰係数の標準誤差を使った検定は、タイプIII平方和を使った検定と同じである。

(以上!)

2018年9月19日 (水)

久々にスキャン・パネル・データについて考える機会があって(生計のためになんでもやるけど、我ながら節操がない)、そういえば前にこんなの読んだな...と頭をよぎるんだけどよく思い出せないということが続き、どんよりした気分になった。頭の整理のため、このブログに記録した範囲で、スキャン・パネル・データを分析している論文のリストをつくってみた。

そういえば、2011年から2012年にかけては意識してスキャン・パネル・データ関連の奴を読むように心がけていたんだよな... 勤務先が変わったこともあって... あの頃の私は多少は誠実であった... 最近はなんだかもう疲れちゃって...

分類は適当である。すいません、これほんとに個人的な覚え書きなんです。

ブランド選択:

- Abramson, et al. (2000) 消費者選択の多項ロジットモデルにおけるパラメータのバイアス (2011/05)

- Andrews, Ainslie, & Currim (2002) 有限混合モデル vs. 階層ベイズモデル ~選択データ分析での対決~ (2012/04)

- Lemon & Nowlis (2002) 販促とブランドのシナジー構築 (2011/06)

- van Heerde, Gupta, & Wittink (2003) 販促の効果に占めるスイッチングは君が思うよりずっと小さい (2012/04)

- Varki, S. & Chintagunta, P.K. (2004) 一部の世帯が複数セグメントに所属することを許す購買行動セグメンテーション (2012/05)

- Chib, Seetharaman, & Strijnev (2004) スキャナー・パネル・データのための「買わない」選択肢つきブランド選択モデル (2012/04)

- Erdem, Zaho, & Valenzuela, A. (2004) アメリカでPBが売れない理由を購買データだけで突き止める (2012/04)

複数カテゴリの購買:

- Manchanda et al. (1999) 複数カテゴリ購買生起モデル (2011/12)

- Russell&Petersen(2000) 複数カテゴリ購買の確率モデル・最終章 (2012/03)

- Chib, Seetharaman, & Strijney (2002) 複数カテゴリ購買の多変量プロビットモデル (2011/12)

- Seetharaman, et al. (2005) 複数カテゴリの選択モデルレビュー (2011/12)

- Boztug & Hildebrandt (2005) 多変量ロジットモデルでバスケット分析 (2011/12)

ブランド購買:

購入数量:

- Chandon & Wansink (2002) 買い置きを使ってしまうのはいつ?(2011/06)

- Bell, Iyer, & Padmanabhan (2002) 値引きが買い置きやカテゴリ消費増大をもたらすような商品カテゴリにおける価格競争 (2011/06) ※ゲーム理論的モデル

購入価格:

購買間隔:

- Jain & Vilcassim (1991) 購買タイミングの比例ハザードモデル (クラシカル・バージョン) (2013/06)

- Seetharaman & Chintagunta (2003) 購買タイミングの比例ハザードモデル (2013/04)

- Fader, Hardie & Huang (2004) 新製品販売予測の動的変化点モデル (2011/06)

- Seetharaman(2004) 購買データを分析するみなさん、比例ハザードモデルばっかり使ってないで加法リスクモデルをお使いなさい (2013/05)

店舗レベルで分析しているもの:

- Pauwels, Hanssens, & Siddarth (2002) 値引きの長期的功罪 (2012/04)

- van Heerde, et al. (2000) POSデータによる販促前後売上減の推定 (2011/05)

書籍:

- 守口(2002)「プロモーション効果分析」(2012/02)

- 阿部・近藤(2005)「マーケティングの科学―POSデータの解析」(2011/05)

2018年9月10日 (月)

地球統計学モデルによる空間的推測をやってるとき、コバリオグラムとバリオグラムのちがいについてたびたび混乱したので、メモをとった。というか、ふだん頼りにしているDiggle&Ribeiro(2010)って、このくだりについては結構わかりにくいような気がするのである。(←理解力の低さをさりげなく他人のせいにする)

瀬谷・堤「空間統計学」5.2節のメモ。話がややこしくなるので異方性の話は省略する。

観測地点$\mathbf{s}_i$($i=1,\ldots,n$)における観測値を$y(\mathbf{s}_i)$とし、

$y(\mathbf{s}_i) = Y(\mathbf{s}_i) + \epsilon(\mathbf{s}_i)$

$\epsilon(\mathbf{s}_i)$は平均0, 分散$\sigma_\epsilon^2$, iidとする。

ついでに共分散関数を定義しておこう。任意の$\mathbf{s}, \mathbf{h}$について、

$C(\mathbf{s}, \mathbf{h})$

$= Cov[Y(\mathbf{s}), Y(\mathbf{s}+\mathbf{h})]$

$= E[\{Y(\mathbf{s}) - m(\mathbf{s})\}\{ Y(\mathbf{s}+\mathbf{h}) - m(\mathbf{s}+\mathbf{h}) \}$

ここで$m(\mathbf{s})$は空間過程の期待値である。

さて、空間過程が強定常であるとは、確率変数$\{Y(\mathbf{s}_1), \cdots, Y(\mathbf{s}_n)\}$によって構成される多変量分布の分布関数が、任意の移動に関して不変であるということである。

強定常性は強すぎる仮定なので緩和し、1次モーメントと2次モーメントの定常性だけを仮定することにしたい。そこでふたつのアプローチが生じる。

その1、弱定常性(二次定常性)。

任意の$\mathbf{s}, \mathbf{h}$について以下が成り立つと仮定する。

$E[Y(\mathbf{s})] = m(\mathbf{s}) = \bar{m}$

$Cov[Y(\mathbf{s}), Y(\mathbf{s}+\mathbf{h})] = C(\mathbf{h})$

$Cov[Y(\mathbf{s}), Y(\mathbf{s}+\mathbf{0})] = Var[Y(\mathbf{s})] = C(\mathbf{0})$

つまり、2地点間の共分散が$\mathbf{h}$の関数だと捉えているわけである。いいかえると、変数の一次モーメントと二次モーメントが定常だと考えている。

その2、固有定常性。

任意の$\mathbf{s}, \mathbf{h}$について以下が成り立つと仮定する。

$E[Y(\mathbf{s}+\mathbf{h}) - Y(\mathbf{s})] = \mathbf{0}$ [あれ?右辺はなぜ太字なの?]

$Var[Y(\mathbf{s}+\mathbf{h})-Y(\mathbf{s})] = 2\gamma(\mathbf{h})$

つまり、2地点の差の分散が$\mathbf{h}$の関数だと捉えているわけである。いいかえると、変数の差の一次モーメントと二次モーメントが定常だと考えている。

[ここでいつも混乱するのだが... 二次定常であれば固有定常だが、逆は成り立たない。つまり、二次定常性のほうが強い仮定である。ってことで合ってますかね?]

さて。

$C(\mathbf{h})$を二次定常共分散関数、またはコバリオグラムという。次の性質を持つ。

有界である: $|C(\mathbf{h})| \leq C(\mathbf{0})$

対称である: $C(-\mathbf{h}) = C(\mathbf{h})$

分散は非負である: $C(\mathbf{0}) \geq 0$

$2\gamma(\mathbf{h})$をバリオグラム、$\gamma(\mathbf{h})$をセミバリオグラムという。えーと、バリオグラムってのは差の分散だが、差の期待値は0だと思ってんだから、差の二乗の期待値だと言い換えてもいいわね。

次の性質を持つ。

$\gamma(\mathbf{0}) = 0$

$\gamma(\mathbf{h}) \geq 0$ [原文に誤植があると思うので勝手に直した]

$\gamma(-\mathbf{h}) = \gamma(\mathbf{h})$

固有定常性の下では、バリオグラムは有界ではないかもしれないという点に注意。

二次定常性が満たされていれば、共分散関数とバリオグラムとの間には

$\gamma(\mathbf{h}) = C(\mathbf{0}) - C(\mathbf{h})$

という関係が成り立つ。

空間予測を可能にするためには、共分散関数は非負定値性、バリオグラムは条件付き非正定値性を満たさなければならないんだけど、ややこしいので省略して...

バリオグラムの形状は、ナゲット、シル、レンジの3つで規定される。ナゲットは切片(正確に言うと、$\mathbf{h}$を$0$に近づけた時の極限値)、シルは空間過程の分散、レンジは$Y(\mathbf{s})$と$Y(\mathbf{s}+\mathbf{h})$が相関を持たなくなる最小の$\mathbf{h}$である。

具体例を挙げよう。

例1、線形バリオグラム。

$||h||=0$のとき $\gamma(\mathbf{h}) = 0$

$||h||>0$のとき $\gamma(\mathbf{h}) = \tau^2 + \sigma^2 ||\mathbf{h}||$

$\tau^2$がナゲットで、シルとレンジは無限大。

共分散関数は存在しない。このように、バリオグラム・モデルというのは文字通りバリオグラムのモデルなのであって、共分散のモデルではない。ああそうか、ここで私は混乱していた...

例2、指数型バリオグラム。

$||h||=0$のとき $\gamma(\mathbf{h}) = 0$

$||h||>0$のとき $\gamma(\mathbf{h}) = \tau^2 + \sigma^2[1-\exp(-\phi ||\mathbf{h}||)]$

$\tau^2$がナゲット。シル$\tau^2 + \sigma^2$は漸近的にしか到達できず、レンジは無限大なので、セミバリオグラムがシルの95%を達成する距離$3/\phi$のことを有効レンジと呼ぶ。

共分散関数は、

$||h||=0$のとき $C(\mathbf{h}) = \tau^2+\sigma^2$

$||h||>0$のとき $C(\mathbf{h}) = \sigma^2 \exp(-\phi^2||\mathbf{h}||^2)$

となる。

...ってな感じですね。端的にいっちゃうと、セミバリオグラム$\gamma(\mathbf{h})$は$\mathbf{h}$とともに上がっていく関数、コバリオグラム$C(\mathbf{h})$は下がっていく関数である。いまのどっちの話をしてんだか、注意せんといかん。

2018年8月12日 (日)

GLMM(一般化線形混合モデル)のRパッケージMCMCglmmというのがあるんだけど、その使い方があまりにヤヤコシイ(少なくとも私にとっては)。必要になるたびに資料をめくり、用事が終わるたびにすぐに忘れてしまう、という繰り返しで、流石にうんざりしてきたので、まとめてメモをとることにする。

参照した資料は以下の通り。

- パッケージのマニュアル。

- パッケージのビニエット。たぶん、前に読んだJSS論文と同じだと思う。

- 著者によるCourse Notes。これも昨年ひととおり目を通したのだけれど、そのときからずいぶん加筆されているような気がする。

- 著者による、2010年のチュートリアル。この資料の位置づけはよくわからない。Course Notesの旧版かと思ったのだが、ここにしか載っていない情報もあるようだ。

概念

最初に基本的な概念の説明から。

MCMCglmmでは、まず反応変数$y_i$の確率密度を

$f_i (y_i | l_i)$

とする。そういわれるとわかりにくいが、たとえばポアソン分布、ログリンクであれば、ポアソン密度関数を$f_P$として

$f_P(y_i | \exp(l_i))$

である。リンク関数で変換する前の変数$l$を潜在変数と呼ぶ。

潜在変数のベクトルを$\mathbf{l}$とする。これは個体レベルの話じゃなくて、たとえ単純なガウシアン回帰でも、100人いたら長さ100である。さらに反応変数が複数あったり、(反応変数が単一でも)潜在変数が複数あったりする場合、それを全部縦に積む。だから$\mathbf{l}$はすごく長い。

固定効果を持つ説明変数の計画行列を$\mathbf{X}$, ランダム効果を持つ説明変数の計画行列を$Z$として、線型モデル

$\mathbf{l} = \mathbf{X \beta} + \mathbf{Z u} + \mathbf{e}$

を考える。潜在変数に残差項$\mathbf{e}$が入っている点にご注目。これは測定誤差ではない。ポアソン・モデルであれば、この項でover-dispersionを説明することになる。

MCMCglmmは、係数はすべてMVNに従うと考え

$\mathbf{u} \sim N(\mathbf{0},\mathbf{G})$

$\mathbf{e} \sim N(\mathbf{0}, \mathbf{R})$

とする(これはデータ生成メカニズム)。$\mathbf{G}, \mathbf{R}$は巨大な正方行列である。なお、事前分布は逆ウィシャート分布である模様。

さらに、MCMCglmmはベイジアン・アプローチに立つので、固定効果の係数$\mathbf{\beta}$でさえ確率変数であり、

$\mathbf{\beta} \sim N(\beta_0, \mathbf{B})$

だと考える(これは事前分布)。

実行例

MCMCglmmパッケージ所収のサンプルデータBTdataには、Blue tit(アオガラ)という鳥についてのデータがはいっている。828行, 行はひなの個体を表す。変数は: